在PHP开发领域,获取网页内容(即发起HTTP请求)是构建爬虫、调用API接口以及实现微服务架构通信的基础技能,经过对多种技术方案的深入对比与实战验证,我们可以得出一个核心上文小编总结:

对于简单的单次请求,

file_get_contents

配合流上下文是最快捷的选择;但在追求高稳定性、复杂交互以及生产环境性能的场景下,cURL 扩展无疑是PHP中处理HTTP请求的黄金标准,而 Guzzle 等第三方库则提供了更现代化的开发体验。

基础方案:file_get_contents 的便捷与局限

file_get_contents

是PHP中最基础的文件读取函数,它同样支持读取网络流,对于不需要复杂HTTP头控制、超时设置或特殊认证的简单GET请求,这是最简洁的代码实现方式。

这种便捷性背后隐藏着明显的局限性,它难以处理复杂的请求场景,例如无法直接发送POST数据,或者无法精细设置超时时间。

file_get_contents

在处理错误时不够直观,往往只能通过判断返回值或抑制错误符来处理,缺乏对HTTP状态码的精准捕获,最重要的是,如果服务器配置中

allow_url_fopen

被关闭,该方法将彻底失效。

为了增强其功能,开发者通常会使用

stream_context_create

创建流上下文,通过它来设置请求头、超时时间甚至POST数据,虽然这扩展了基础函数的能力,但代码的可读性和维护性会随着参数的增加而急剧下降。

进阶核心:cURL 扩展的全面掌控

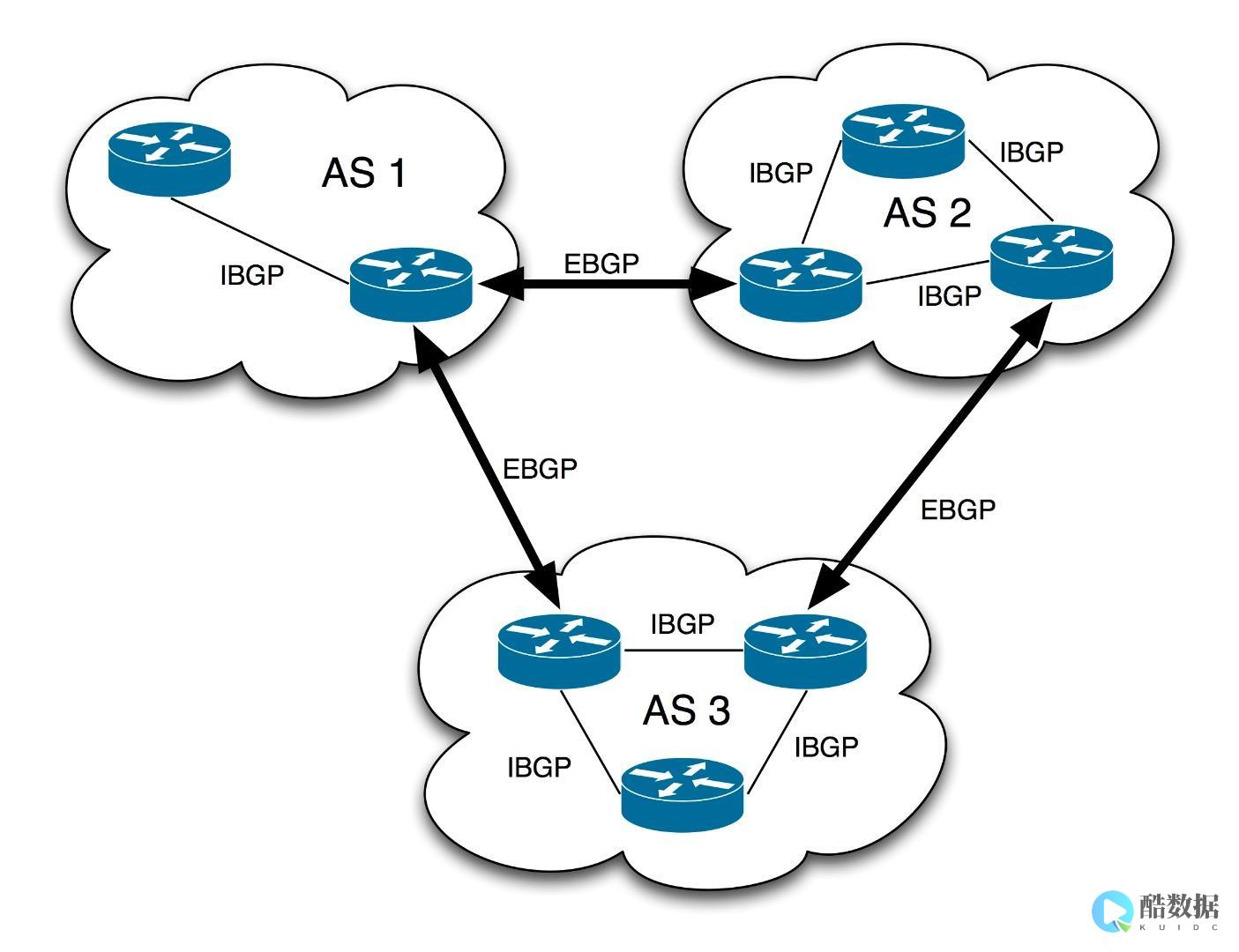

在专业级开发中, cURL(client URL Library)是获取网页内容的首选方案 ,它不仅支持HTTP/HTTPS协议,还支持FTP、Telnet等多种协议,提供了对HTTP请求的细粒度控制。

cURL 的强大之处在于其丰富的配置选项,通过

curl_setopt

,开发者可以轻松模拟各种浏览器行为,例如设置

User-Agent

来伪装访问来源,设置

CURLOPT_FOLLOWLOCATION

自动处理301/302重定向,以及通过

CURLOPT_TIMEOUT

和 **CURLOPT_CONNECTTIMEOUT` 严格控制连接和执行的超时时间,防止脚本因网络问题而假死。

在处理POST请求时,cURL 允许发送

application/x-www-form-urlencoded

或

multipart/form-data

格式的数据,这对于提交表单或调用RESTful API至关重要,cURL 原生支持

SSL证书验证

,在处理HTTPS请求时,可以灵活配置证书路径或选择跳过验证(仅限开发环境),确保了数据传输的安全性,对于需要更高性能的批量任务,cURL 的

curl_multi

系列函数支持多线程并发请求,能显著提升数据采集效率。

现代化开发:GuzzleHttp 库的封装优势

随着PHP生态的发展,使用 Composer 管理依赖已成为标准。 GuzzleHttp 是目前最流行的PHP HTTP客户端,它实质上是对 cURL 的高度封装,但提供了更加符合 PSR-7 标准的接口和异常处理机制。

使用 Guzzle 的最大优势在于 代码的简洁性和可维护性 ,它将复杂的 cURL 配置抽象为链式调用,使得发送异步请求、中间件拦截、请求重试等高级功能的实现变得异常简单,Guzzle 内置了“中间件”系统,允许开发者在请求发送前后插入自定义逻辑(如日志记录、统一签名),这对于构建大型企业级应用至关重要。

独家经验案例: 酷番云 在数据采集中的实战应用

在为

酷番云

开发云服务器资源监控与竞品价格分析系统时,我们面临着一个严峻的技术挑战:需要高频次、高并发地访问多个公有云厂商的API接口,初期使用

file_get_contents

导致频繁的超时和内存溢出,严重影响了监控数据的实时性。

基于此,我们采用了基于 cURL 的多线程并发方案 ,并将其部署在 酷番云的高性能计算型云服务器 上,具体的优化策略包括:

这一实战经验证明, 优秀的代码实现必须依托于稳定的基础设施 ,通过将专业的PHP cURL 技术与酷番云的高性能网络环境相结合,我们成功构建了一个稳定、低延迟的数据采集系统。

安全与性能优化的专业建议

无论选择哪种方法获取网页内容, 安全性 始终是不可逾越的红线,永远不要信任从外部获取的数据,必须对返回的内容进行严格的过滤和验证,防止XSS攻击或代码注入,在处理用户输入的URL时,必须验证URL的合法性,防止SSRF(服务器端请求伪造)攻击,确保服务器不会被利用去攻击内网或其他外部站点。

在性能方面,除了使用并发技术外, 合理的缓存策略 也是关键,对于不经常变动的网页内容,应利用 Redis 或 Memcached 将获取到的内容缓存一段时间,避免重复请求,减轻服务器压力并加快响应速度。

相关问答

Q1:在PHP中,file_get_contents 和 cURL 在处理HTTPS请求时有什么主要区别?

file_get_contents

在处理HTTPS时,往往需要繁琐的流上下文配置来处理SSL证书验证,且容易遇到证书不通过时的报错,难以排查,而 cURL 对HTTPS有原生且强大的支持,可以通过

CURLOPT_SSL_VERIFYPEER

和

CURLOPT_SSL_VERIFYHOST

灵活控制证书验证级别,并且能更清晰地处理SSL握手失败的错误信息,是生产环境处理HTTPS的首选。

Q2:如何解决

PHP获取网页内容

时出现的中文乱码问题?

中文乱码通常是因为目标网页的编码(如GBK)与当前脚本或数据库的编码(如UTF-8)不一致,最专业的解决方案是:首先通过 cURL 获取响应头的

Content-Type

来识别目标编码,或者使用

mb_detect_encoding

自动检测,使用

mb_convert_encoding

或函数将获取到的原始内容统一转换为 UTF-8 编码,确保后续处理逻辑的一致性。

希望这篇文章能帮助你在PHP开发中更精准地选择网页内容获取方案,如果你在实战中遇到过关于 cURL 并发性能优化的难题,或者有更好的解决思路,欢迎在评论区分享你的经验!

发表评论