离谱!面试为啥都问kafka?赶紧补一下

2023-11-01 07:25:54Apache Kafka是一个高吞吐量、分布式、可水平扩展的消息传递系统,最初由LinkedIn开发。它的目标是解决海量数据的实时流式处理和传输问题。

大家好,我是哪吒。

Kafka几乎是当今时代背景下数据管道的首选,无论你是做后端开发、还是大数据开发,对它可能都不陌生。开源软件Kafka的应用越来越广泛。

面对Kafka的普及和学习热潮,哪吒想分享一下自己多年的开发经验,带领读者比较轻松地掌握Kafka的相关知识。

Apache Kafka是一个高吞吐量、分布式、可水平扩展的消息传递系统,最初由LinkedIn开发。它的目标是解决海量数据的实时流式处理和传输问题。

Kafka的核心思想是将数据转化为流,并以发布-订阅的方式传递。

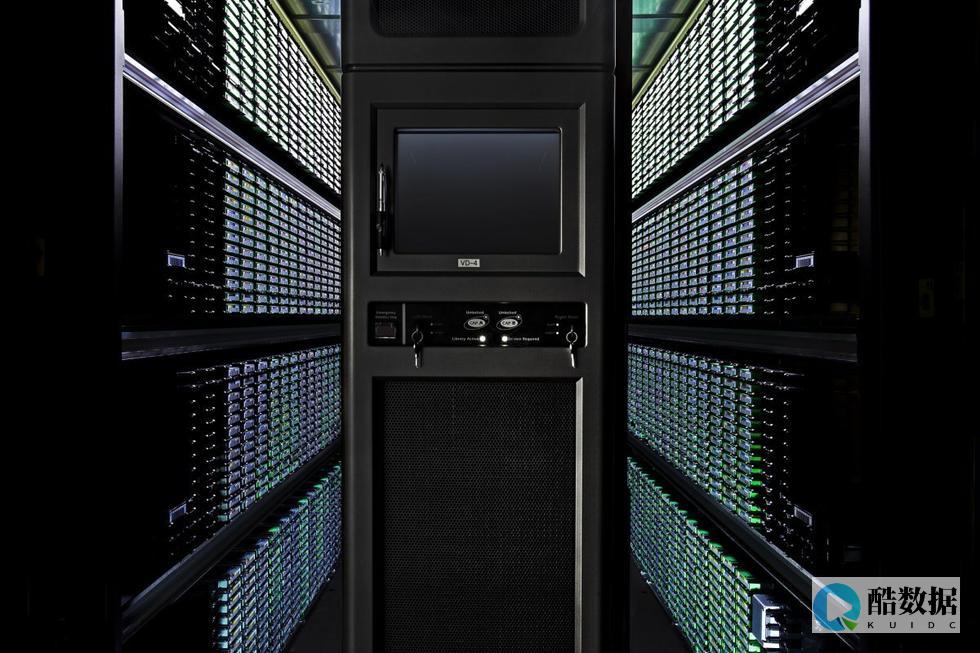

上图描述了Kafka的核心概念和数据流向。从中可以看出,生产者将消息发布到主题,消费者订阅主题并处理消息,而主题可以分为多个分区,以支持消息的并行处理和提高可伸缩性。

二、为什么需要批处理和流处理?

批处理和流处理是Kafka的两种核心处理模式,它们在不同的应用场景中起到关键作用。理解它们的应用背景和差异有助于更好地利用Kafka的潜力。

批处理 是一种将数据按批次收集和处理的模式。它适用于需要处理大量历史数据的任务,如报表生成、离线数据分析、批量ETL(Extract, Transform, Load)等。

批处理通常会在固定的时间间隔内运行,处理大量数据并生成结果。它具有以下特点:

流处理 是一种实时数据处理模式,它可以连续地处理流入的数据。它适用于需要实时响应的应用,如实时监控、实时推荐、欺诈检测等。流处理使数据立即可用,它具有以下特点:

为了充分发挥Kafka的优势,我们需要同时理解和使用这两种模式,根据具体需求在批处理和流处理之间切换。例如,在大多数实际应用中,数据会以流的形式进入Kafka,然后可以通过流处理工具进行实时处理,同时,历史数据也可以作为批处理任务周期性地处理。

Kafka默认的分区策略是Round-Robin,这意味着消息将依次分配给每个分区,确保每个分区接收相似数量的消息。这种默认策略适用于具有相似数据量和处理需求的分区情况。在这种策略下,Kafka会轮流将消息写入每个分区,以保持负载的均衡性。对于大多数一般性的应用场景,这种默认策略通常已经足够了。

尽管默认分区策略适用于大多数情况,但有时候你可能需要更加灵活的分区策略。这时,你可以使用自定义分区策略,根据特定需求将消息路由到不同的分区。最常见的情况是,你希望确保具有相同键(Key)的消息被写入到同一个分区,以维护消息的有序性。

自定义分区策略的示例代码如下:

public class CustomPartitioner implements Partitioner {@Overridepublic int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster) {List partitions = cluster.partitionsForTopic(topic);int numPartitions = partitions.size();// 根据消息的键来选择分区int partition = Math.abs(key.hashCode()) % numPartitions;return partition;}@Overridepublic void close() {// 关闭资源}@Overridepublic void configure(Map configs) {// 配置信息}} 自定义分区策略允许你更灵活地控制消息的路由方式。在上述示例中,根据消息的键来选择分区,确保具有相同键的消息被写入到同一个分区,以维护它们的有序性。

3、最佳实践:如何选择分区策略

选择分区策略应该根据你的具体需求和应用场景来进行。以下是一些最佳实践建议:

选择适当的分区策略可以帮助你优化Kafka的性能和消息处理方式,确保你的应用能够以最佳方式处理消息。

四、批处理与流处理简介

批处理 是一种数据处理方式,它按照固定的时间间隔或固定的数据量来收集、处理和分析数据。批处理适用于那些不需要实时响应的任务,如数据报表生成、大规模数据清洗、离线数据分析等。

在批处理中,数据通常存储在一个集中的位置,然后周期性地批量处理。这个处理周期可以是每天、每周或根据业务需求的其他时间间隔。批处理任务会在处理过程中消耗大量资源,因为它需要处理整个数据集。

流处理 是一种实时数据处理方式,它能够连续地处理流入的数据。流处理适用于需要实时响应的应用,如实时监控、实时推荐、欺诈检测等。

在流处理中,数据会立即被处理,而不需要等待批次的积累。这使得流处理能够提供低延迟的数据处理,以满足实时应用的要求。流处理通常用于处理事件流,监控传感器数据等需要实时性的数据源。

3、批处理与流处理的区别

批处理和流处理有以下区别:

为了充分发挥Kafka的优势,你需要同时理解和使用这两种处理模式,并根据具体需求在批处理和流处理之间切换。这将使你的应用能够以最佳方式处理不同类型的数据。

批处理在许多应用场景中发挥着关键作用,特别是在需要处理大量历史数据的任务中。以下是一些批处理应用场景的示例:

|

应用场景 |

描述 |

|

报表生成 |

每天、每周或每月生成各种类型的报表,如销售报表、财务报表、运营分析等。 |

|

离线数据分析 |

对历史数据进行深入分析,以发现趋势、模式和异常情况。 |

|

数据仓库填充 |

将数据从不同的数据源提取、转换和加载到数据仓库,以供查询和分析。 |

|

大规模ETL |

将数据从一个系统转移到另一个系统,通常涉及数据清洗和转换。 |

|

批量图像处理 |

处理大量图像数据,例如生成缩略图、处理滤镜等。 |

典型的批处理架构包括以下组件:

|

组件 |

描述 |

|

数据源 |

|

|

数据处理 |

批处理任务的核心部分,包括数据的提取、转换和加载(ETL),以及任何必要的计算和分析。 |

|

数据存储 |

批处理任务期间,中间数据和处理结果的存储位置,通常是关系型数据库、NoSQL数据库、分布式文件系统等。 |

|

结果生成 |

批处理任务的输出,通常包括生成报表、填充数据仓库等。 |

(1)数据缓冲

在批处理中,处理大量数据时需要考虑数据缓冲,以提高性能和有效管理数据:

(2)状态管理

状态管理对于批处理非常关键,它有助于确保任务的可靠执行、恢复和容错性:

(3)错误处理

错误处理是批处理过程中的关键部分,可以确保任务的可靠性和数据质量:

这些策略在批处理中的综合使用,可以确保任务以可靠、高效和容错的方式执行,满足性能和质量需求。根据具体的应用场景,可以根据需求调整这些策略。

下面是一个简单的示例,演示如何使用Kafka进行批处理。

public class KafkaBatchProcessor {public static void main(String[] args) {Properties props = new Properties();props.put("bootstrap.servers", "localhost:9092");props.put("group.id", "batch-processing-group");props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");KafkaConsumer consumer = new KafkaConsumer<>(props);consumer.subscribe(Collections.singletonList("batch-data-topic"));// 批处理逻辑while (true) {ConsumerRecords records = consumer.poll(Duration.ofMillis(100));for (ConsumerRecord record : records) {// 处理消息processRecord(record.value());}}}private static void processRecord(String record) {// 实现批处理逻辑System.out.println("Processing record: " + record);}} 在这个示例中,我们创建了一个Kafka消费者,订阅了名为batch-data-topic的消息主题。消费者会定期拉取消息,并调用processRecord方法来处理每条消息。

这个示例展示了如何将Kafka用于批处理任务的数据源,但实际的数据处理逻辑可能更加复杂,具体取决于应用的需求。批处理任务通常会包括数据提取、转换、处理和结果生成等步骤。

流处理适用于需要实时响应的应用场景,其中数据不断流入系统并需要立即处理。以下是一些流处理应用场景的示例:

流处理应用通常需要满足低延迟、高吞吐量和高可伸缩性的要求,以确保数据的及时性和质量。

流处理架构通常包括以下关键组件:

Kafka在流处理架构中常用作数据源和数据存储,流处理框架用于处理数据流。这些组件共同协作,使流处理应用能够实时响应和分析数据。

(1)事件时间处理

事件时间处理是流处理的重要策略,特别适用于需要处理带有时间戳的事件数据的情况。事件时间表示事件发生的实际时间,而非数据到达系统的时间。流处理应用程序需要正确处理事件时间以确保数据的时序性。这包括处理乱序事件、延迟事件、重复事件等,以保持数据的一致性。

(2)窗口操作

窗口操作是流处理的核心概念,它允许我们将数据分割成不同的时间窗口,以进行聚合和分析。常见的窗口类型包括滚动窗口(固定大小的窗口,随时间滚动前进)和滑动窗口(固定大小的窗口,在数据流中滑动)。窗口操作使我们能够在不同时间尺度上对数据进行摘要和分析,例如,每分钟、每小时、每天的数据汇总。

(3)依赖处理

流处理应用通常包括多个任务和依赖关系。管理任务之间的依赖关系非常关键,以确保数据按正确的顺序处理。依赖处理包括任务的启动和关闭顺序、数据流的拓扑排序、故障恢复等。这确保了任务之间的一致性和正确性,尤其在分布式流处理应用中。

这些策略和关键概念共同确保了流处理应用的可靠性、时效性和正确性。它们是构建实时数据应用的基础,对于不同的应用场景可能需要不同的调整和优化。

在这个示例中,我们演示了如何使用Kafka Streams进行流处理。以下是示例代码的详细解释:

首先,我们创建一个Properties对象,用于配置Kafka Streams应用程序。我们设置了应用程序的ID和Kafka集群的地址。

Properties props = new Properties();props.put(StreamsConfig.APPLICATION_ID_CONFIG, "stream-processing-app");props.put(StreamsConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");然后,我们创建一个StreamsBuilder对象,它将用于构建流处理拓扑。

StreamsBuilder builder = new StreamsBuilder();我们使用builder从名为stream-data-topic的Kafka主题中创建一个输入数据流。

KStream source = builder.stream("stream-data-topic"); 接下来,我们对数据流执行一系列操作。首先,我们使用filter操作筛选出包含”important-data”的消息。

source.filter((key, value) -> value.contains("important-data"))然后,我们使用mapValues操作将筛选出的消息的值转换为大写。

.mapValues(value -> value.toUpperCase())最后,我们使用to操作将处理后的消息发送到名为output-topic的Kafka主题。

.to("output-topic");最后,我们创建一个KafkaStreams对象,将builder.build()和配置属性传递给它,然后启动流处理应用程序。

KafkaStreams streams = new KafkaStreams(builder.build(), props);streams.start();这个示例展示了如何使用Kafka Streams轻松地构建流处理应用程序,对消息进行筛选和转换,然后将结果发送到另一个主题。这使得实时数据处理变得相对简单,且具有高度的可伸缩性和容错性。

七、集成批处理与流处理

数据流整合是将批处理和流处理相结合的过程。它允许在处理数据时,根据数据的特性切换处理模式,从而更好地满足应用程序的需求。数据流整合可以通过使用不同的工具和库来实现,以便在数据处理过程中无缝切换。

数据流整合通常需要进行数据转换,以确保数据可以在批处理和流处理之间无缝流转。这可能包括以下方面:

将数据从批处理传递到流处理,或反之,需要合适的数据传递机制。Kafka是一个出色的数据传递工具,因为它可以方便地支持数据传递。在Kafka中,批处理任务可以将数据写入特定的批处理主题,而流处理任务可以从这些主题中读取数据。这使得批处理和流处理之间的协同变得更加容易。

4、最佳实践:批处理与流处理的协同应用

当你需要在实际应用中集成批处理与流处理时,下面是一些更详细的操作步骤和示例代码:

步骤1:根据需求选择合适的处理模式

步骤2:数据转换和数据传递

步骤3:合适的监控和日志

步骤4:测试和评估

示例代码

以下是一个简单的示例,展示如何使用Kafka作为数据传递机制来集成批处理与流处理。假设我们有一个批处理任务,它从文件中读取数据并将其写入Kafka主题,然后有一个流处理任务,它从同一个Kafka主题中读取数据并进行实时处理。

批处理任务(使用Apache Spark):

import org.apache.spark.SparkConf;import org.apache.spark.api.Java.JavaRDD;import org.apache.spark.api.java.JavaSparkcontext;import org.apache.spark.streaming.Duration;import org.apache.spark.streaming.api.java.JavaDStream;import org.apache.spark.streaming.api.java.JavaStreamingContext;import org.apache.spark.streaming.kafka.KafkaUtils;import java.util.HashMap;import java.util.HashSet;import java.util.Map;import java.util.Set;public class BatchToStreamIntegration {public static void main(String[] args) {SparkConf sparkConf = new SparkConf().setAppName("BatchToStreamIntegration");JavaSparkContext sparkContext = new JavaSparkContext(sparkConf);JavaStreamingContext streamingContext = new JavaStreamingContext(sparkContext, new Duration(5000));Map topicMap = new HashMap<>();topicMap.put("input-topic", 1);JavaDStream messages = KafkaUtils.createStream(streamingContext, "zookeeper.quorum", "group", topicMap).map(consumerRecord -> consumerRecord._2());messages.foreachRDD((JavaRDD rdd) -> {rdd.foreach(record -> processRecord(record));});streamingContext.start();streamingContext.awaitTermination();}private static void processRecord(String record) {System.out.println("Batch processing record: " + record);}} 流处理任务(使用Kafka Streams):

import org.apache.kafka.streams.KafkaStreams;import org.apache.kafka.streams.StreamsBuilder;import org.apache.kafka.streams.StreamsConfig;import org.apache.kafka.streams.kstream.Consumed;import org.apache.kafka.streams.kstream.KStream;import java.util.Properties;public class StreamToBatchIntegration {public static void main(String[] args) {Properties props = new Properties();props.put(StreamsConfig.APPLICATION_ID_CONFIG, "stream-to-batch-app");props.put(StreamsConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");StreamsBuilder builder = new StreamsBuilder();KStream source = builder.stream("input-topic", Consumed.with(Serdes.String(), Serdes.String()));source.foreach((key, value) -> {processRecord(value);});KafkaStreams streams = new KafkaStreams(builder.build(), props);streams.start();}private static void processRecord(String record) {System.out.println("Stream processing record: " + record);}} 这两个示例演示了如何使用不同的工具来实现批处理与流处理的集成。

肯德基面试的问题?有经验者进!

肯德基面试实录 今天下午2:30,我来到大学城的肯德基面试。 原来今天又10多人来面试,面试还没有开始,我找了个地方坐下。 坐在我对面的一对情侣,口音不像广州的,寒暄了几句也就罢了。 不久,面试人员也出来了,是一个中年男人,面试随着展开——在离面试团不远的一张桌子。 在我之前有4个人面试,都是女的,我都认真观察了他们。 个人认为他们都有一个通病,就是和面试官的动作一样,手都是放在桌子上。 这是一个即时地位的问题,但可能面试官也不会看出吧。 还有一个女竟让人看到了她的鞋底,就算面试官看不见,在场的服务经理也会看见。 鞋底,是一身打扮中最难看的地方,干嘛要把它展示出来呢? 一肚子理论,终于到我了。 很奇怪,到我的时候不是面试官走过来点名,而是一个服务员来着我的简历来叫我,我回应他也不望微笑,因为每一个微笑是有其价值的,据我所知,世界上最贵的微笑值15万美金。 我拿着简历慢慢向面试官走去,并借此机会想着怎样做才好,当我把简历放下的那一刻我知道自觉做错了,简历不是向着面试官而是向着自己,要面试官自己掉转过来。 我站了几秒,本想面试官叫我坐我才坐,但是他好像没有意识到,我就自己轻轻拉了一下椅子就坐下了。 我屁股坐得比较后,身子微微前倾(这是想听前辈说话的坐姿),双手放在牛仔裤的拉链位上,把一条裤最不好看的地方遮住。 我准备好了,他就响我发起攻击了。 他:“你八点以后有事情做吗?” 我:“是上午八点还是晚上八点?” 他:“晚上。 ” 我:“没有。 ” 他:“为什么简历上写的工作时间只是到八点呢?” 我:“你们提供的选择只有上午十点到晚上八点。 ” 他:“那只是一个范例而已。 ” 我:(啊!系喔!)“那我可以做到晚上十点。 ” 他:“你知道肯德基的关门时间吗?” 我:(啊!扑街!)“这我不清楚。 ” 他:“你住在哪里?” 我:“广大生活区B24宿舍。 ” 他:“这里为什么写新港西路?” 我:“这是我家的地址,我星期1-7都可以在学校。 ” 他:“你不回家吗?” 我:(这里是中国)“我比较独立,爸妈他们都很放心。 ” 他:“你读大几了?” 我:“大二。 ” 他:“你问什么想在肯德基工作?” 我:(终于问了)“肯德基是属于百胜饮食集团——世界第一的快餐饮食集团,除了肯德基之外,还有Pizza Hut 和 Taco Bell,在这里工作不只是当一名员工而已,还能学到很多东西。 ” 虽然看着面试官的面孔很好笑,好像出乎意料,但我觉得自己说错了,我没有表现出一名服务员应有的素质和热情,这样说是不是有点反客为主呢? 面试结束了,他说我被录取了的话就会今天之内通知我,反之。 总的来说还是表现不错,全程都带着虚伪但必要的笑容,而且走的时候还将椅子往里面靠了一下,我觉得这很重要,还是那一句,不知道面试官的是不是我想象的那种人。

如果我去面试肯德基

首先会让你自我介绍,你就简单介绍下自己就好了,记住一定要说自己的工作经历,接下来就是一些提问了 1.你为什么来肯德基,这个可以说喜欢这里的工作环境或者像锻炼下,可能也会问你是怎么知道肯德基招人的,还有就是有没有朋友在肯德基工作,他们跟你说了什么关于肯德基的事,这个一定要说有,然后就说朋友们说肯德基管理比较严格但是在这里工作很快乐 2.以前的工作经历问你为什么结束了上一份工作 3.你认为上一份工作给你什么经验,这个就说要服务热情啊,微笑啊等等 4.你在学校的工作,这个说在学生会的工作,尽量说得有工作能力 5.最重要的就是时间问题了,面试经理会问你可不可以在某个时间段工作,如果你真的想在这里干的话就说可以,有困难的话说自己可以克服 6.说说自己的兴趣爱好 大概就这些了,面试的时候一定要面带微笑,不要紧张,回答问题的时候看着经理的眼睛~我前几天刚刚通过了肯德基的面试,下个星期就能上班了,祝你好运,加油哦~~~^0^ zai石家庄 你去红旗大街找找 哟额的 多的去了 你慢慢找个合适你的 交个朋友 谢谢采纳

面试时,如何向面试官提问题?

在面试结束前,大多数的主考官都会丢问题给求职者,最常见的就是:你有没有什么问题或疑问,想要提出来的?无论求职者是否有提出问题,其实,这个问题背后的真正含意,通常是主考官用来测试你对这份工作有多大的企图心、决心和热情。 因此,如果你害怕发问不妥当,或是不知道该从何问起,甚至回答没有问题时,都很可能会让主考官认为,你想要这份工作的企图心、决心还不够强。 相反的,求职者应该更积极、主动的利用面试最后一关的机会,适时的提出问题,这不但有助于主考官对你的印象能够加深,而且你也能趁此机会进一步了解这家公司的背景、企业文化是否适合你。 最重要的是,如果能够在面试时,提出漂亮的问题,录取的机率将会大大提高。 所以,无论如何,前往面试前,先谨记10个可以反问主考官的问题,以便到时候可以提出。 1.贵公司对这项职务的工作内容和期望目标为和?有没有什么部分是我可以努力的地方?2.贵公司是否有正式或非正式教育训练?3.贵公司的升迁管道如何?4.贵公司的多角化经营,而且在海内外都设有分公司,将来是否有外派、轮调的机会?5.贵公司能超越同业的最大利基点为何?6.在项目的执行分工上,是否有资深的人员能够带领新进者,并让新进者有发挥的机会?7.贵公司强调的团队合作中,其它的成员素质和特性如何?8.贵公司是否鼓励在职进修?对于在职进修的补助办法如何?9.贵公司在人事上的规定和作法如何?10.能否为我介绍一下工作环境,或者是否有机会能参观一下贵公司?至于薪水待遇、年假天数、年终奖金、福利措施等问题,有些公司的主考官在面试时,会直接向求职者提出。 如果对方没有提及,对社会新鲜人来说,在找第一份工作时,比较不适合提出,除非你有对方不得不录取你的条件。

发表评论