服务器 算力5倍GPU方案

一、背景与需求分析

随着人工智能和高性能计算需求的迅速增长,传统CPU服务器在处理大量并行计算任务时显得力不从心,GPU(图形处理器)凭借其强大的并行计算能力,逐渐成为这些领域的主流选择,如何有效提升服务器的算力,以满足日益复杂的计算需求,成为业界关注的焦点,本文将探讨一种通过增加GPU数量来实现服务器算力提升五倍的方案。

二、现状评估

现有服务器配置

:Intel Xeon E5-2600系列

内存 :64GB DDR4

存储 :1TB SSD + 2TB HDD

显卡 :NVIDIA GTX 1080 Ti

当前算力水平

理论峰值算力 :约11 TFLOPS(浮点运算次数/每秒)

实际应用中的表现 :受限于CPU与GPU之间的数据传输瓶颈及优化不足,实际性能往往只能达到理论值的一部分。

三、目标设定

总体目标 :将现有服务器的算力提高至少五倍。

具体指标 :

理论峰值算力 > 55 TFLOPS

实际运行效率接近或达到理论值的70%

支持更多并发任务处理

保持成本效益比合理

四、技术选型与架构设计

GPU选择

根据最新市场调研结果和技术发展趋势,推荐使用 NVIDIA A100 Tensor Core GPU作为主要加速卡,该款GPU基于最新的Ampere架构,具备以下优势:

高性能

:单精度浮点数运算能力高达19.5 TFLOPS,双精度也能达到9.7 TFLOPS。

高性能

:单精度浮点数运算能力高达19.5 TFLOPS,双精度也能达到9.7 TFLOPS。

大内存带宽 :配备432GB/s的HBM2显存,能够快速加载并处理大规模数据集。

多实例GPU技术 :允许将单个物理GPU分割成多个独立的逻辑单元,从而提高资源利用率。

系统架构设计

采用混合架构模式,结合CPU+GPU以及可能引入的其他加速器如FPGA等,构建一个高效能、低延迟的 异构计算平台 。

CPU负责逻辑控制 :包括任务调度、数据预处理等轻量级操作。

GPU专注于密集型计算 :利用其强大的并行处理能力执行深度学习训练、科学模拟等工作。

高速互联接口 :确保CPU与GPU之间通信顺畅无阻,减少等待时间。

软件优化策略

除了硬件层面的升级外,还需要对软件栈进行相应调整以充分发挥新硬件的性能潜力:

CUDA编程模型 :针对NVIDIA GPU开发专门的内核函数,实现算法层面的优化。

深度学习框架集成 :如TensorFlow、PyTorch等主流框架均已良好支持NVIDIA GPU,可直接利用其提供的API接口简化开发流程。

容器化部署 :利用Docker等工具打包应用程序及其依赖环境,便于跨不同节点快速部署测试。

五、实施步骤

硬件采购与安装

根据预算选择合适的GPU型号和数量。

完成物理服务器的组装调试工作。

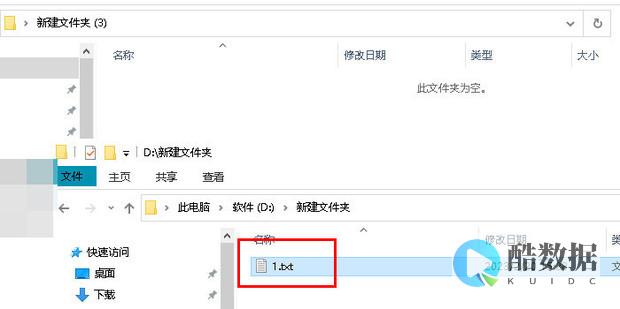

操作系统配置

安装最新版本的Linux发行版作为基础操作系统。

配置必要的驱动程序和服务。

软件环境搭建

安装CUDA Toolkit及相关库文件。

设置虚拟环境管理器以便隔离不同项目间的依赖关系。

性能测试验证

使用标准基准测试套件评估改造后系统的综合表现。

对比改造前后差异,确认是否达到预期目标。

持续监控维护

定期检查硬件状态,预防潜在故障发生。

根据实际使用情况动态调整资源配置比例。

六、成本效益分析

| 项目 | 单价(元) | 数量 | 总价(元) |

| 内存 | |||

| 硬盘 | |||

| 主板/电源/机箱等其他配件 | |||

| 总计 |

预计总投资约为87.8万元人民币左右,考虑到由此带来的显著性能提升及长期运营成本节约,这笔开销是值得的投资。

七、相关问题与解答栏目

Q: 如何选择合适的GPU?

: 选择GPU时应考虑以下因素:性能指标(如TFLOPS)、显存大小、功耗、价格以及是否有良好的社区支持和文档资料,对于本方案而言,推荐选择NVIDIA A100或RTX 3090 Ti,它们均能满足大部分应用场景的需求并提供出色的性价比。

2. Q: 如果未来需要进一步扩展算力怎么办?

: 若需继续扩充算力,则可以通过两种方式实现:一是在同一台机器上添加更多的GPU;二是增加更多的节点组成集群,前者适用于空间充足且电力供应允许的情况;后者则更适合构建大规模分布式系统来解决极其复杂的问题,还可以探索云服务提供商提供的弹性计算服务来临时获取额外资源。

到此,以上就是小编对于“ 服务器算力5倍gpu方案 ”的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位朋友在评论区讨论,给我留言。

CPU生产厂家有几家

Intel公司创建于1968年。 在短短的二十多年内,创下令人瞩目的辉煌成就。 1971年推出全球第一个微处理器,1981 年,IBM采用Intel生产的8088微处理器推出全球第一台IBM PC机,1984年入选全美一百家最值得投资的公司,1992年成为全球最大的半导体集成电路厂商,1994年其营业额达到了118亿美元,在CPU市场大约占据了80%份额。 Intel 领导着CPU的世界潮流,从286、386、486、Pentium、昙花一现的Pentium Pro、Pentium II 、Pentium III到现在主流的Pentium 4,它始终推动着微处理器的更新换代。 Intel的CPU不仅性能出色,而且在稳定性、功耗方面都十分理想。 AMD 创办于1969 年,总公司设于美国硅谷。 是集成电路供应商,专为电脑、通信及电子消费类市场供应各种芯片产品,其中包括用于通信及网络设备的微处理器、闪存、以及基于硅片技术的解决方案等。 AMD是唯一能与Intel竞争的CPU生产厂家,AMD公司的产品现在已经形成了以Athlon XP及Duron为核心的一系列产品。 AMD公司认为,由于在CPU核心架构方面的优势,同主频的AMD处理器具有更好的整体性能。 但AMD处理器的发热量往往比较大,选用的时候在系统散热方面多加注意,在兼容性方面可能也需要多打些补丁。 AMD的产品的特点是性能较高而且价格便宜。 VIA CyrixⅢ(C3)处理器是由威盛公司生产的,其最大的特点就是价格低廉,性能实用,对于经济比较紧张的用户具有很大的吸引力。

怎么比较CPU好坏?

CPU主要的性能指标有:·主频主频也叫时钟频率,单位是MHz,用来表示CPU的运算速度。 CPU的主频=外频×倍频系数。 很多人认为主频就决定着CPU的运行速度,这不仅是个片面的认识,而且对于服务器来讲,这个认识也出现了偏差。 至今,没有一条确定的公式能够实现主频和实际的运算速度两者之间的量值关系,即使是两大处理器厂家Intel和AMD,在这点上也存在着很大的争议,我们从Intel的产品的发展趋势,可以看出Intel很注重加强自身主频的发展。 像其他的处理器生产厂家,有人曾经拿过一块1G的全美达来做比较,它的运行效率相当于2G的Intel处理器。 所以,CPU的主频与CPU实际的运算能力是没有直接关系的,主频表示在CPU内数字脉冲信号震荡的速度。 在Intel的处理器产品中,我们也可以看到这样的例子:1 GHz Itanium芯片能够表现得差不多跟2.66 GHz Xeon/Opteron一样快,或是1.5 GHz Itanium 2大约跟4 GHz Xeon/Opteron一样快。 CPU的运算速度还要看CPU的流水线的各方面的性能指标。 当然,主频和实际的运算速度是有关的,只能说主频是CPU性能表现的一个方面,而不能代表CPU的整体性能。 ·外频 外频是CPU的基准频率,单位也是MHz。 CPU的外频决定着整块主板的运行速度。 说白了,在台式机中,我们所说的超频,都是超CPU的外频(当然一般情况下,CPU的倍频都是被锁住的)相信这点是很好理解的。 但对于服务器CPU来讲,超频是绝对不允许的。 前面说到CPU决定着主板的运行速度,两者是同步运行的,如果把服务器CPU超频了,改变了外频,会产生异步运行,(台式机很多主板都支持异步运行)这样会造成整个服务器系统的不稳定。 目前的绝大部分电脑系统中外频也是内存与主板之间的同步运行的速度,在这种方式下,可以理解为CPU的外频直接与内存相连通,实现两者间的同步运行状态。 外频与前端总线(FSB)频率很容易被混为一谈,下面我们在前端总线的介绍中谈谈两者的区别。 ·前端总线(FSB)频率 前端总线(FSB)频率(即总线频率)是直接影响CPU与内存直接数据交换速度。 有一条公式可以计算,即数据带宽=(总线频率×数据位宽)/8,数据传输最大带宽取决于所有同时传输的数据的宽度和传输频率。 比方,现在的支持64位的至强Nocona,前端总线是800MHz,按照公式,它的数据传输最大带宽是6.4GB/秒。 外频与前端总线(FSB)频率的区别:前端总线的速度指的是数据传输的速度,外频是CPU与主板之间同步运行的速度。 也就是说,100MHz外频特指数字脉冲信号在每秒钟震荡一千万次;而100MHz前端总线指的是每秒钟CPU可接受的数据传输量是100MHz×64bit÷8bit/Byte=800MB/s。 其实现在“HyperTransport”构架的出现,让这种实际意义上的前端总线(FSB)频率发生了变化。 之前我们知道IA-32架构必须有三大重要的构件:内存控制器Hub (MCH) ,I/O控制器Hub和PCI Hub,像Intel很典型的芯片组 Intel 7501、Intel7505芯片组,为双至强处理器量身定做的,它们所包含的MCH为CPU提供了频率为533MHz的前端总线,配合DDR内存,前端总线带宽可达到4.3GB/秒。 但随着处理器性能不断提高同时给系统架构带来了很多问题。 而“HyperTransport”构架不但解决了问题,而且更有效地提高了总线带宽,比方AMD Opteron处理器,灵活的HyperTransport I/O总线体系结构让它整合了内存控制器,使处理器不通过系统总线传给芯片组而直接和内存交换数据。 这样的话,前端总线(FSB)频率在AMD Opteron处理器就不知道从何谈起了。

GPU的浮点运算能力为什么会如此恐怖

GPU主要是进行是进行图形渲染的 有人说GPU的性能达到CPU的40倍这个说法是很不全面的 如果光说GPU在并行和密集浮点运算上达到CPU40倍性能这个或许可行(个人认为没有这么夸张,最好的GPU能达到最好的CPU的10倍就很令人吃惊的了,况且现在CPU出现了多核,这使CPU的运算大大提高了,而GPGPU貌似还限于单核),但在全运算上这么说就很没根据了 其实把GPU当作普通处理器使用依然有着不小的难度,其中最要命的恐怕就是GPU是被专门设计来处理图形,因此它的编程语言架构和编程环境都难通用。 GPU运行非图形程序时,往往需要依靠极其复杂的算法和较为曲折的流程,GPU的强大运算潜力很多时候就在这样的迂回过程中被一点点耗尽。 除此以外,由于没有统一的API和驱动支持,GPU程序的开发者不得不针对每个GPU架构开发对应的软件版本,使得把GPU当作普通处理器项目的推进难度倍增。

发表评论