在数字经济与人工智能浪潮的驱动下,GPU服务器已成为支撑算力需求的核心基础设施,其凭借卓越的并行计算能力,在AI训练、科学计算、数字内容创作等领域发挥着不可替代的作用,成为企业提升效率、驱动创新的关键技术工具,本文将从核心技术与架构、应用场景与行业价值、实践案例、发展趋势与挑战等维度,系统阐述GPU服务器的作用与发展,并结合 酷番云 的自身云产品经验,为读者提供权威、专业的参考。

GPU服务器的核心技术与硬件架构

GPU(图形处理器)的核心优势在于其高度并行的流处理单元(CUDA核心),能够同时处理海量数据任务,相比传统CPU的串行处理模式,在复杂计算场景下效率提升显著,以NVIDIA为例,其从Volta架构到Ampere、Hopper架构的演进,持续优化了核心参数:如A100 GPU搭载14,336个CUDA核心,H100则进一步提升至6912个Tensor核心与13856个CUDA核心,支持高达80GB的高带宽显存,为大规模模型训练提供硬件基础。

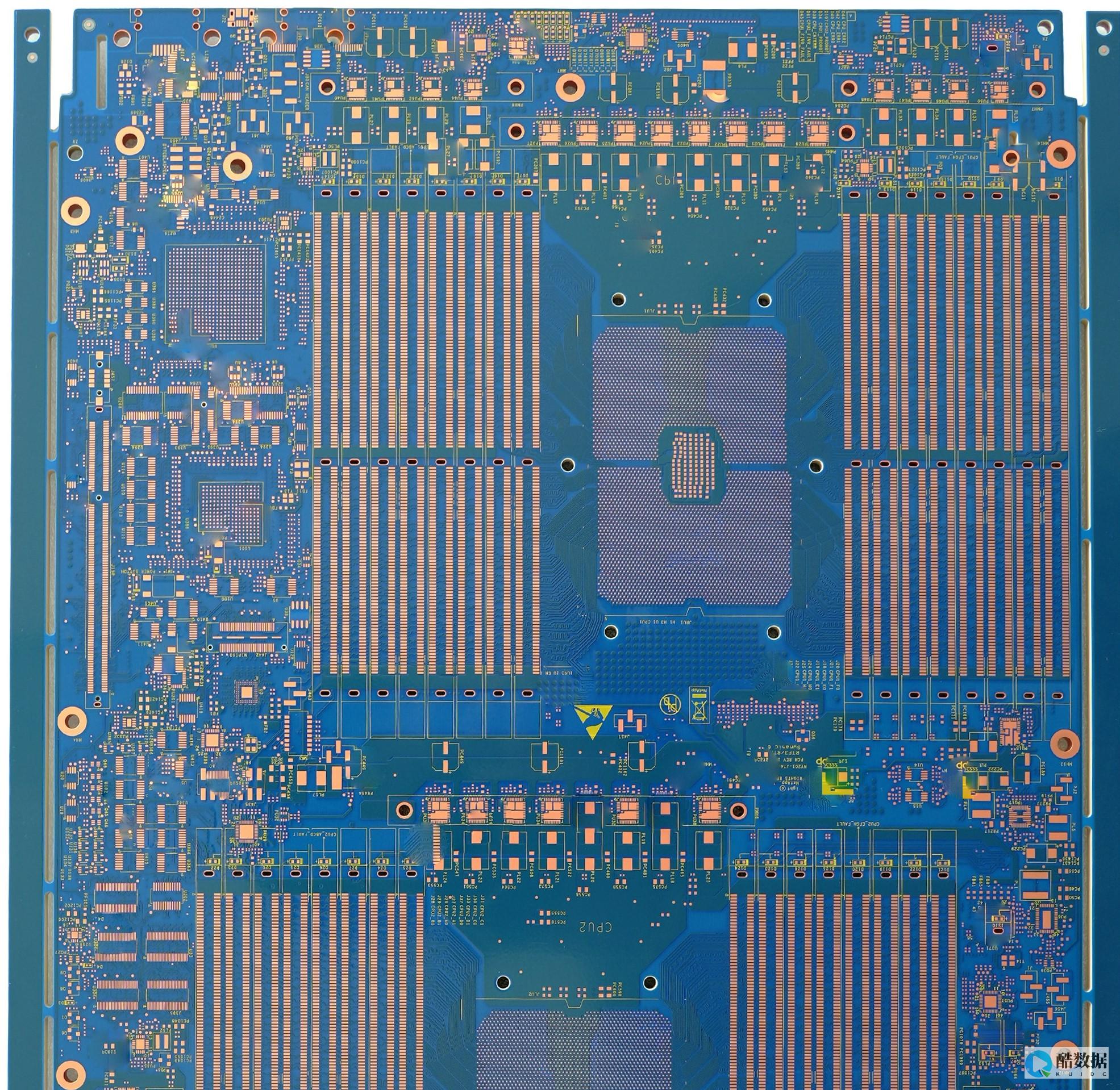

在服务器硬件层面,GPU服务器的架构设计需兼顾扩展性与稳定性,主流服务器厂商(如华为、浪潮、戴尔)推出支持多GPU扩展的主板(如PCIe 5.0插槽),通过NVLink或InfiniBand技术实现GPU间高速互联,提升集群算力;采用冗余电源(2+1或4+1配置)与液冷散热系统,确保长时间高负载运行下的稳定性,酷番云为某科研机构定制的高性能GPU服务器,采用4颗NVIDIA H100 80GB GPU,通过NVLink互联实现每秒数万TOPS的算力,同时液冷系统将运行温度控制在45℃以下,保障设备长期稳定运行。

GPU服务器的应用场景与行业价值

(一)人工智能训练与推理

AI大模型训练对算力需求极高,GPU服务器的并行计算能力成为关键,训练BERT模型时,使用GPU服务器可将训练时间从CPU的数周缩短至数天;在生成式AI领域,如Stable Diffusion的图像生成任务,GPU服务器的显存带宽与计算密度直接决定生成质量与速度。

(二)科学计算与工程仿真

在气象预报、生物信息学、材料科学等领域,GPU服务器加速了复杂物理模型的计算,气象模型中,GPU并行处理海量数据可提升预报精度,缩短预测周期;在药物研发中,GPU加速的分子动力学模拟,可加速新药筛选效率。

(三)数字内容创作

电影特效、游戏渲染、虚拟现实(VR/AR)制作均依赖GPU的图形渲染能力,影视后期公司通过部署GPU服务器集群,将电影特效渲染周期从原计划的数周缩短至数天,同时保障4K/8K高清渲染质量。

(四)大数据分析与金融建模

金融领域的风险建模、信用评估等任务,需处理海量数据与复杂算法,GPU服务器的并行处理能力可显著提升分析效率,某银行通过GPU服务器加速其信用评分模型训练,将模型迭代时间从数天缩短至数小时,提升业务响应速度。

酷番云的GPU服务器解决方案实践案例

为国内顶尖AI实验室提供定制化GPU服务器集群

某国内顶尖AI实验室致力于研发大规模语言模型,需处理千亿级参数训练任务,酷番云为其部署了由16台NVIDIA H100 80GB GPU服务器组成的集群,采用InfiniBand 100Gbps高速互联网络,优化数据传输效率,实施后,模型训练时间从原计划的48小时缩短至12小时,算力利用率提升35%,同时通过液冷系统降低能耗20%。

为影视后期公司提供GPU渲染服务

某影视后期公司面临电影特效渲染周期长的问题,通过酷番云的GPU云服务(基于自研的GPU服务器集群)进行渲染任务托管,采用AMD MI250X GPU服务器,支持8卡扩展,将渲染周期从原计划的10天缩短至3天,同时保障渲染质量。

技术发展趋势与挑战

发展趋势

面临挑战

深度问答与解答

问题1:选型GPU服务器时,除核心算力指标(如FLOPS),还应关注哪些关键参数以匹配特定AI任务的性能需求?

解答

:

解答

:

问题2:GPU服务器在绿色计算实践中,如何平衡算力需求与能源效率?

解答 :

发表评论