分布式系统如何做负载均衡

在分布式系统中,负载均衡是一项核心机制,旨在通过合理分配请求流量,避免单一节点过载,同时最大化系统资源利用率、提升整体性能和可用性,随着业务规模的增长和用户量的激增,负载均衡已成为构建高可用、高扩展性系统的关键技术,本文将从负载均衡的基本原理、常见算法、实现方式、实践挑战及未来趋势等方面,系统探讨分布式系统中负载均衡的实现方法。

负载均衡的核心目标与价值

负载均衡的核心目标在于优化资源分配,确保系统高效稳定运行,其价值主要体现在以下几个方面:

负载均衡的关键算法选择

负载均衡算法直接影响流量分配的合理性,常见的算法包括以下几种:

轮询(Round Robin)

轮询算法将请求按顺序分配到各个节点,适用于所有节点性能相近的场景,其实现简单,但无法考虑节点的实际负载差异,可能导致性能不均。

加权轮询(Weighted Round Robin)

通过为不同节点分配不同权重,实现流量的差异化分配,高性能节点可设置更高权重,接收更多请求,该算法适用于节点性能差异较大的场景,但需合理调整权重以避免资源浪费。

最少连接(Least Connections)

将请求分配给当前连接数最少的节点,动态反映节点的实时负载情况,该算法能更好地应对突发流量,避免部分节点因连接过多而响应缓慢。

一致性哈希(Consistent Hashing)

通过哈希函数将请求映射到特定节点,确保相同请求(如同一用户会话)始终被分配到同一节点,该算法常用于缓存系统、数据库分片等场景,可减少数据迁移成本,但需处理节点增删时的数据重平衡问题。

自适应算法

结合多种策略(如动态权重、实时负载监控),通过机器学习或启发式规则调整流量分配,根据节点的CPU使用率、响应时间等指标动态选择最优节点,实现更精细化的负载管理。

负载均衡的实现方式

负载均衡可通过硬件或软件实现,具体选择需根据系统规模、成本预算和性能需求综合考量。

硬件负载均衡器

硬件负载均衡器(如F5 BIG-IP、A10)通过专用设备提供高性能的流量处理能力,支持SSL卸载、流量整形等高级功能,其优势在于稳定性和高性能,但成本较高,扩展性受限于硬件容量,适用于大型企业级应用。

软件负载均衡器

软件负载均衡器(如Nginx、HAProxy、Envoy)通过开源或商业软件实现,具有灵活性和成本优势。

云负载均衡服务

云服务商(如AWS ELB、阿里云SLB、 酷番云 CLB)提供托管的负载均衡服务,支持自动扩缩容、全局负载均衡等功能,用户无需关注底层基础设施,按需付费,适合快速迭代的互联网应用。

负载均衡的实践挑战与解决方案

尽管负载均衡技术成熟,但在实际部署中仍面临诸多挑战,需结合场景优化解决方案。

会话保持(Session Persistence)

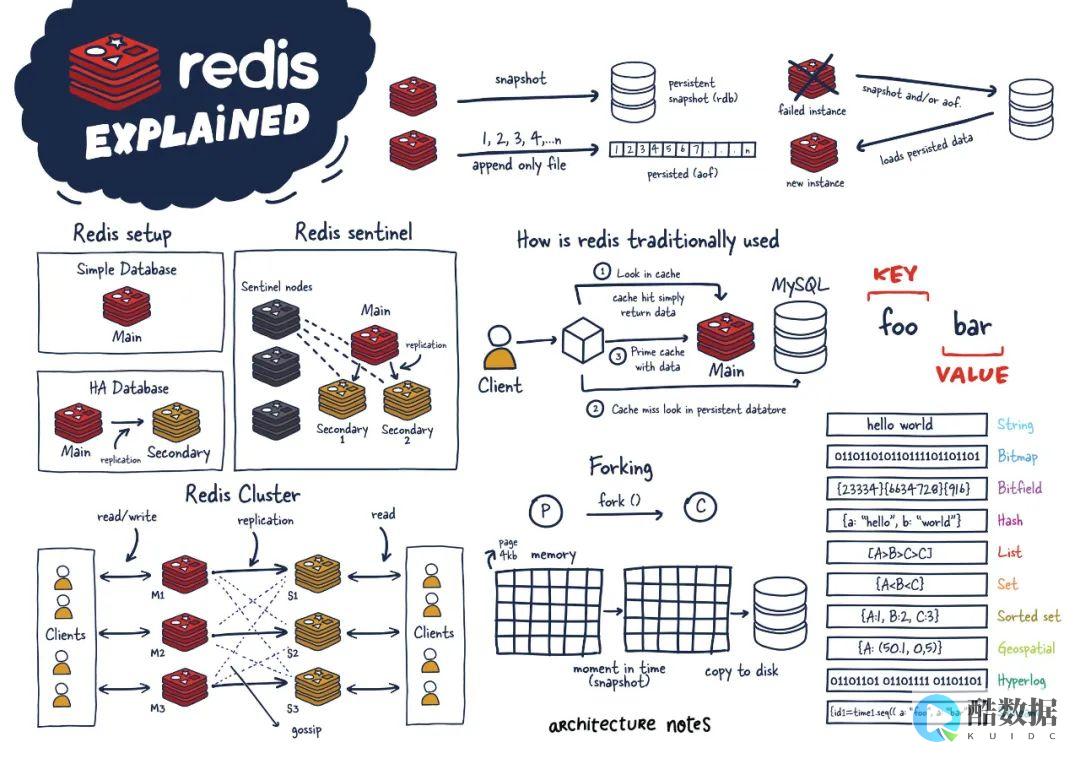

在需要用户状态的业务(如电商购物车)中,需确保同一用户的请求始终分配到同一节点,可通过Cookie、IP哈希或服务器端会话存储(如Redis)实现,但需权衡一致性与扩展性。

健康检查与故障转移

负载均衡器需实时监控节点状态,及时发现故障并隔离节点,可通过心跳检测、HTTP接口检查等方式实现健康检查,并结合自动扩缩容策略(如Kubernetes HPA)动态调整节点数量。

全局负载均衡(GSLB)

对于跨地域部署的系统,需根据用户位置、网络延迟等因素分配流量,可通过DNS轮询、Anycast等技术实现全局负载均衡,优化用户访问体验。

数据一致性

在分布式数据库或缓存系统中,负载均衡可能导致数据分片不一致,需结合一致性哈希或分布式事务协议(如Paxos、Raft)确保数据同步。

未来趋势与演进方向

随着云计算和微服务架构的普及,负载均衡技术也在持续演进:

负载均衡是分布式系统的“交通枢纽”,其设计需兼顾性能、可用性与扩展性,在实际应用中,需根据业务场景选择合适的算法和实现方式,并通过持续监控与优化应对动态变化的需求,随着技术的不断演进,负载均衡将更加智能化、自动化,为构建下一代分布式系统提供坚实支撑。

发表评论