云计算作为现代数字基础设施的核心模式,经历了从传统IaaS到GPU云计算的演进,传统云计算以通用CPU为核心,满足Web服务、数据库等通用计算需求;而GPU云计算则是基于GPU(图形处理器)的专用计算服务,针对AI、科学计算等高并行任务,两者在架构、性能、场景、成本等维度有何本质区别?本文将结合行业实践与权威分析,深入解析GPU云计算与传统云计算的核心差异。

硬件架构与核心差异

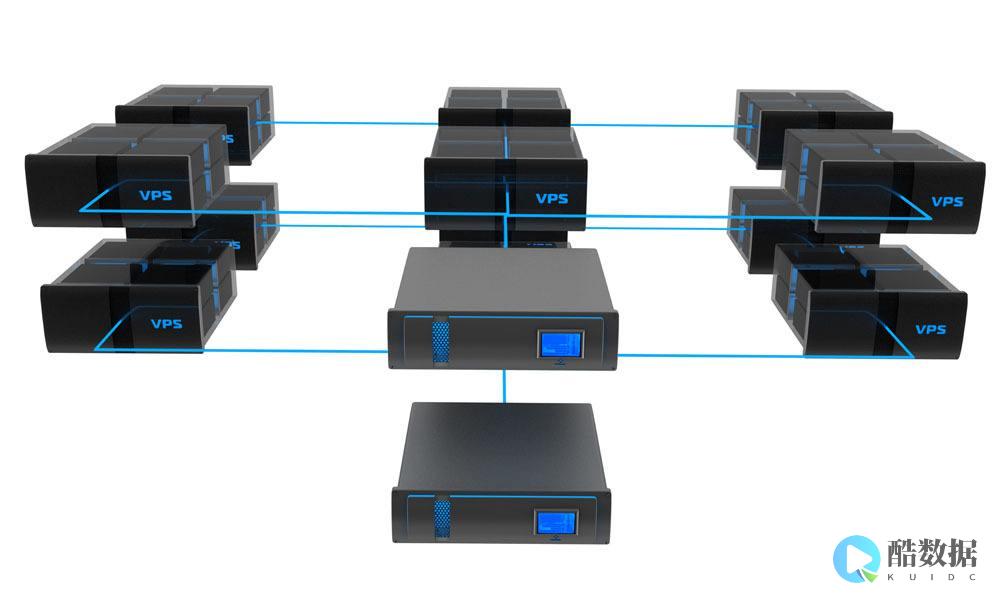

传统云计算的底层硬件以多核CPU为主,采用冯·诺依曼架构,擅长串行计算任务(如逻辑控制、数据处理),适用于通用业务(如Web应用、文件存储),而GPU云计算则采用异构计算架构,以GPU为核心,集成数千个流处理器,支持高度并行的计算模式,特别适合矩阵运算、图像处理等密集型计算任务(如深度学习模型训练、3D渲染),架构差异直接决定了计算任务的适配性:CPU擅长逻辑控制与串行计算,GPU擅长并行计算与数据密集型任务。

性能维度:算力与数据处理能力

在算力上,GPU的浮点运算性能远超CPU,以主流NVIDIA A100 GPU为例,其FP16单精度算力可达312 TFLOPS,而同等规格的Intel Xeon CPU的浮点算力约为CPU的10-20倍,在数据处理能力上,GPU的内存带宽(如A100的900GB/s)远高于CPU(如Xeon的200GB/s),能高效处理大规模数据集,这种性能优势在AI训练、科学模拟、视频渲染等场景下体现明显:深度学习模型训练时,GPU可大幅缩短训练周期(如ResNet-50模型训练,GPU仅需数小时,而CPU需数天)。

应用场景:传统云与GPU云的适配性

传统云计算适用于通用业务,如Web应用、数据库操作等,这些任务对算力要求不高,CPU即可满足,而GPU云计算则聚焦于高并行计算场景,如AI模型训练与推理、3D渲染、金融风控、生物信息学等,在AI研发领域,GPU云是主流选择(如TensorFlow、PyTorch等框架均支持GPU加速);在金融科技领域,GPU用于风险模型训练(如信用评分模型);在影视制作领域,GPU用于3D动画渲染。

成本与资源调度:资源利用率与成本控制

传统云计算的CPU资源利用率较高,适合通用任务,成本相对较低,而GPU云计算的成本受GPU资源稀缺性影响,价格较高(如NVIDIA A100 GPU的租赁价格约为CPU的3-5倍),但可通过资源调度优化降低成本, 酷番云 通过智能调度系统,根据任务需求动态分配GPU资源,在AI训练项目中,将多个小任务合并到GPU集群中,提升资源利用率,降低单任务成本,具体案例:某金融公司使用酷番云GPU云服务进行风险模型训练,通过资源调度,将多个模型训练任务合并到同一GPU集群,相比传统云方案,成本降低约30%,训练时间缩短40%。

从架构、性能、场景、成本等维度,GPU云计算与传统云计算存在显著差异,传统云侧重通用计算,GPU云聚焦高并行计算,二者互补,共同构成现代云计算生态。

相关问答FAQs

CPU和GPU组合怎样发挥各自优点?

CPU作为通用处理器,具有“全能性”,也因为CPU的用途,覆盖的运算方面很广,而GPU作为图形处理器,具有强悍的单一运算能力,有高度的并行运算性,作为一种协处理器,也是CPU的运算助手

java中,什么是云计算?

广义云计算是指服务的交付和使用模式,指通过网络以按需、易扩展的方式获得所需的服务。 这种服务可以是IT和软件、互联网相关的,也可以是任意其他的服务。 解释: 这种资源池称为“云”。 “云”是一些可以自我维护和管理的虚拟计算资源,通常为一些大型服务器集群,包括计算服务器、存储服务器、宽带资源等等。 云计算将所有的计算资源集中起来,并由软件实现自动管理,无需人为参与。 这使得应用提供者无需为繁琐的细节而烦恼,能够更加专注于自己的业务,有利于创新和降低成本。 有人打了个比方:这就好比是从古老的单台发电机模式转向了电厂集中供电的模式。 它意味着计算能力也可以作为一种商品进行流通,就像煤气、水电一样,取用方便,费用低廉。 最大的不同在于,它是通过互联网进行传输的。 云计算是并行计算(Parallel Computing)、分布式计算(Distributed Computing)和网格计算(Grid Computing)的发展,或者说是这些计算机科学概念的商业实现。 云计算是虚拟化(Virtualization)、效用计算(Utility Computing)、IaaS(基础设施即服务)、PaaS(平台即服务)、SaaS(软件即服务)等概念混合演进并跃升的结果。 总的来说,云计算可以算作是网格计算的一个商业演化版。 早在2002年,我国刘鹏就针对传统网格计算思路存在不实用问题,提出计算池的概念:“把分散在各地的高性能计算机用高速网络连接起来,用专门设计的中间件软件有机地粘合在一起,以Web界面接受各地科学工作者提出的计算请求,并将之分配到合适的结点上运行。 计算池能大大提高资源的服务质量和利用率,同时避免跨结点划分应用程序所带来的低效性和复杂性,能够在目前条件下达到实用化要求。 ”如果将文中的“高性能计算机”换成“服务器集群”,将“科学工作者”换成“商业用户”,就与当前的云计算非常接近了。 云计算具有以下特点: (1) 超大规模。 “云”具有相当的规模,Google云计算已经拥有100多万台服务器, Amazon、IBM、微软、Yahoo等的“云”均拥有几十万台服务器。 企业私有云一般拥有数百上千台服务器。 “云”能赋予用户前所未有的计算能力。 (2) 虚拟化。 云计算支持用户在任意位置、使用各种终端获取应用服务。 所请求的资源来自“云”,而不是固定的有形的实体。 应用在“云”中某处运行,但实际上用户无需了解、也不用担心应用运行的具体位置。 只需要一台笔记本或者一个手机,就可以通过网络服务来实现我们需要的一切,甚至包括超级计算这样的任务。 (3) 高可靠性。 “云”使用了数据多副本容错、计算节点同构可互换等措施来保障服务的高可靠性,使用云计算比使用本地计算机可靠。 (4) 通用性。 云计算不针对特定的应用,在“云”的支撑下可以构造出千变万化的应用,同一个“云”可以同时支撑不同的应用运行。 (5) 高可扩展性。 “云”的规模可以动态伸缩,满足应用和用户规模增长的需要。 (6) 按需服务。 “云”是一个庞大的资源池,你按需购买;云可以象自来水,电,煤气那样计费。 (7) 极其廉价。 由于“云”的特殊容错措施可以采用极其廉价的节点来构成云,“云”的自动化集中式管理使大量企业无需负担日益高昂的数据中心管理成本,“云”的通用性使资源的利用率较之传统系统大幅提升,因此用户可以充分享受“云”的低成本优势,经常只要花费几百美元、几天时间就能完成以前需要数万美元、数月时间才能完成的任务。 云计算可以彻底改变人们未来的生活,但同时也用重视环境问题,这样才能真正为人类进步做贡献,而不是简单的技术提升。

为什么GPU的浮点运算能力比CPU强的多?

GPGPU主要是进行是进行图形渲染的GPGPU的性能达到CPU的40倍这个说法是很不全面的如果光说GPGPU在并行和密集浮点运算上达到CPU40倍性能这个或许可行(个人认为没有这么夸张,最好的GPGPU能达到最好的CPU的10倍就很令人吃惊的了,况且现在CPU出现了多核,这使CPU的运算大大提高了,而GPGPU貌似还限于单核),但在全运算上这么说就很没根据了其实把GPU当作普通处理器使用依然有着不小的难度,其中最要命的恐怕就是GPU是被专门设计来处理图形,因此它的编程语言架构和编程环境都难通用。 GPU运行非图形程序时,往往需要依靠极其复杂的算法和较为曲折的流程,GPU的强大运算潜力很多时候就在这样的迂回过程中被一点点耗尽。 除此以外,由于没有统一的API和驱动支持,GPGPU程序的开发者不得不针对每个GPU架构开发对应的软件版本,使得把GPU当作普通处理器项目的推进难度倍增。 PS:这里说的CPU是人们通常意义上说的CPU简单的说GPU是被专门设计来处理图形一颗主频为3GHz的 Pentium 4处理器的理论浮点计算速度为12GFLOPs/s,而GeForce 8800GTX的计算能力则达到惊人的500GFLOPs/s,与CPU相比,GPU在浮点运算上的优势非常明显弱势:GPU运行非图形程序时,往往需要依靠极其复杂的算法和较为曲折的流程,GPU的强大运算潜力很多时候就在这样的迂回过程中被一点点耗尽。 除此以外,由于没有统一的API和驱动支持,GPGPU程序的开发者不得不针对每个GPU架构开发对应的软件版本,这也使得可实现性难以体现补充回答: 从接口技术和图形图象学上来详细分析这个问题我可能远不够资格了,理论上来说 操作系统是可以运行在CPU上的,先不考虑什么技术可行性只要Cache够大到能装下操作系统,如果把这问题化简单一点,用很大概的价格来看,同容量内存价格大概是硬盘的10倍以上,那么同容量的Cache大概也在内存价格10倍以上,再加上技术的加成性,就现在来说就象用GPU完全代替CPU一样还个未知的难题参考资料:

发表评论