配置Hive数据源的详细指南

Hive是Apache开源的数据仓库工具,专为大规模结构化数据存储、查询与分析设计,配置Hive数据源是连接业务系统(如数据库、文件系统)与Hive的关键环节,直接影响数据同步效率、查询性能及BI分析体验,本文将系统讲解Hive数据源的配置流程、常见问题及优化方法,助力用户高效搭建Hive数据连接。

环境准备

配置Hive数据源前,需先完成基础环境搭建,确保各组件兼容且运行稳定。

| 环境组件 | 具体要求 | 操作说明 |

|---|---|---|

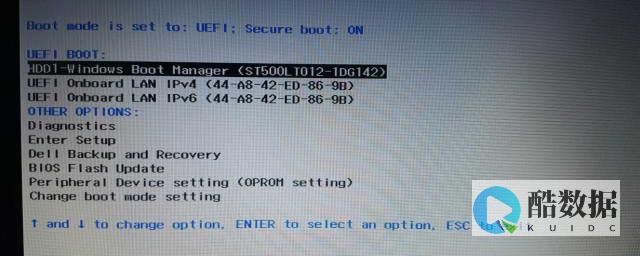

| 操作系统 | Linux(CentOS 7+)或Windows SERVER 2012+ | Linux更推荐,因Hive在Linux下稳定性更高 |

| JDK 8或11 | 下载对应版本,配置环境变量 | |

| Hadoop/HDFS | Hadoop 3.x(NameNode+DataNode) | 安装Hadoop,配置HDFS集群(确保NameNode可访问) |

| Hive 3.x(如3.1.2) | 下载Hive压缩包,解压至指定目录(如) |

Hive环境配置

环境配置包括环境变量设置、Hive核心配置文件修改,确保Hive能正确访问Hadoop HDFS及元数据存储。

设置环境变量

在(Linux)或系统环境变量(Windows)中添加以下变量:

export HIVE_HOME=/opt/hiveexport HIVE_CONF_DIR=/opt/hive/confexport HADOOP_HOME=/opt/hadoopexport PATH=$PATH:$HIVE_HOME/bin:$HADOOP_HOME/bin

执行

source ~/.bashrc

(Linux)或重启系统(Windows)使变量生效。

配置Hive核心文件

数据源连接配置

Hive数据源连接方式主要包括和,不同场景下选择合适的方式可提升效率。

ODBC配置(适用于Windows/Unix系统)

ODBC是跨平台的数据库连接方式,适合通过BI工具(如Tableau)或脚本(如PowerShell)访问Hive。

JDBC配置(适用于Java/Python等编程语言)

JDBC是主流的数据库连接方式,适合在应用中动态访问Hive数据。

工具集成案例

Python(PyHive)连接Hive

安装PyHive库:

pip install pyhive

,示例代码:

from pyhive import hiveconn = hive.Connection(host='localhost', port=10000,, username='hive', password='hive')cur = conn.cursor()cur.execute('select * from user_table limit 10')print(cur.fetchall())

Tableau连接Hive

在Tableau中添加数据源→选择“Hive”→输入JDBC URL、用户名、密码→测试连接→选择表/查询即可。

性能优化建议

常见问题解答(FAQs)

通过以上步骤,可完成Hive数据源的配置,实现业务系统与Hive的高效数据交互。

发表评论