明确需求与场景

在搭建分布式消息系统前,首要任务是明确业务需求和应用场景,不同的业务场景对消息系统的要求差异显著,例如高并发、低延迟、高可用或事务性支持等,常见的应用场景包括:异步通信(如系统解耦)、流量削峰(如电商大促时的订单处理)、数据分发(如日志收集)等,需明确消息的生产速率、消费者处理能力、消息持久化需求、是否需要顺序消费等关键指标,这些将直接影响技术选型和架构设计。

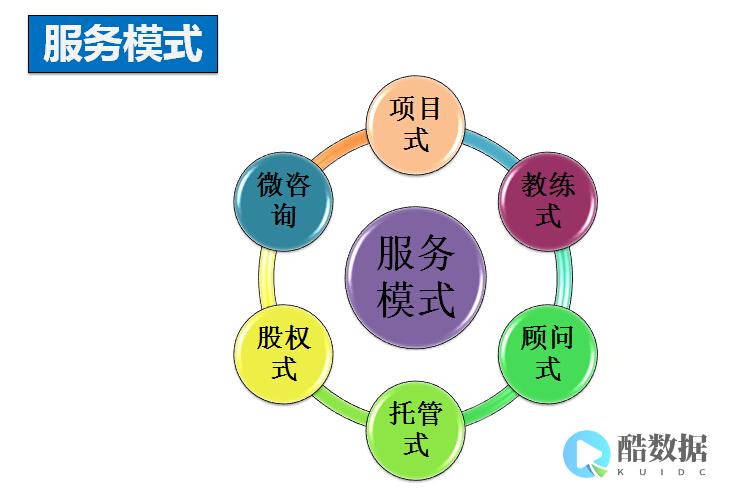

技术选型:核心组件与中间件选择

分布式消息系统的搭建离不开成熟的技术栈,核心组件包括消息中间件、客户端库、协调服务(如ZooKeeper/Kafka的内置协调机制)等,目前主流的消息中间件有Kafka、RabbitMQ、RocketMQ等,需根据需求对比其特性:

需选择配套的客户端库(如Java、Python SDK)和监控工具(如Prometheus+Grafana),确保系统可观测性。

架构设计:高可用与扩展性保障

分布式消息系统的架构需重点考虑高可用、可扩展性和数据一致性,典型架构包括以下层次:

集群部署

消息中间件需采用集群模式避免单点故障,Kafka通过多个Broker(节点)组成集群,数据通过副本机制(Replica)实现冗余;RabbitMQ通过镜像队列(Mirror Queue)将队列数据复制到多个节点,建议至少部署3个节点,确保集群在部分节点故障时仍可提供服务。

分区与分片

为提升并发处理能力,Kafka通过Topic分区(Partition)实现并行消费,每个分区可由独立消费者组处理;RocketMQ通过MessageQueue分片,类似分区机制,分区数量需根据消费者数量和吞吐量合理配置,避免分区过少导致瓶颈,或过多导致资源浪费。

负载均衡

消息生产者需通过负载均衡算法(如轮询、哈希)将消息发送到不同Broker或分区;消费者则通过消费者组(Consumer Group)实现负载均衡,组内每个消费者消费不同分区的消息,避免重复消费。

数据持久化与备份

消息需持久化到磁盘,防止数据丢失,Kafka通过日志段(Log Segment)存储消息,支持配置保留策略(如按时间或大小清理);RabbitMQ可通过启用消息持久化,将队列和消息写入磁盘,需定期备份数据,例如Kafka的副本机制本身提供数据冗余,可结合外部备份工具实现容灾。

关键功能实现

消息可靠性

顺序消费

对于需要严格顺序的场景(如订单支付),需确保单分区内消息有序,Kafka和RocketMQ均支持单分区顺序消费,生产者通过指定分区键(Key)保证消息发送到同一分区,消费者按分区顺序处理。

事务支持

金融等场景需保证消息和业务数据库的一致性,RocketMQ支持事务消息,通过“事务状态表”和事务回查机制,确保消息发送与本地事务同时成功或失败;Kafka可通过事务API(

TransactionalProducer

)实现跨分区事务,但复杂度较高。

运维与监控

系统上线后,需建立完善的运维和监控体系:

安全与性能优化

安全配置

性能优化

通过以上步骤,可搭建一个满足业务需求的分布式消息系统,实际搭建中需结合具体场景灵活调整,并在测试环境充分验证性能和可靠性,确保系统上线后稳定运行。

发表评论