在现代互联网应用架构中,服务器与客户端之间的通信效率直接影响着用户体验和系统性能,长连接(Long-lived Connection)作为一种重要的通信机制,通过保持连接的持久性来减少频繁建立和断开连接的开销,已成为高并发、低延迟场景下的关键技术,本文将从长连接的基本概念、技术实现、优势挑战、应用场景及最佳实践等方面,系统阐述服务器设置长连接的相关知识。

长连接的基本概念与工作原理

长连接是指通信双方在建立连接后,不立即释放,而是持续保持连接状态,通过会话复用实现数据的双向传输,与短连接(每次通信后立即断开连接,下次通信重新建立)相比,长连接的核心在于“连接复用”——连接一旦建立,可在一定时间内承载多次数据交互,避免了TCP三次握手和四次挥手带来的额外开销。

从技术层面看,长连接通常基于TCP协议实现,通过以下机制维持连接活性:

长连接的技术实现方式

服务器实现长连接需结合具体协议和框架设计,常见的技术实现包括以下几种:

基于TCP的原始Socket长连接

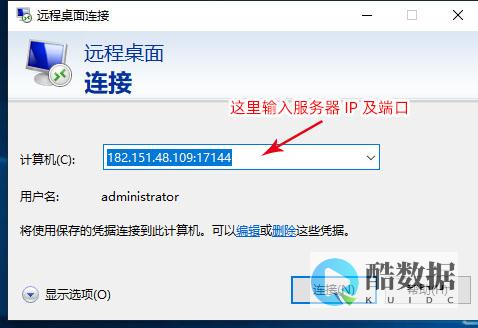

通过操作系统提供的Socket API,开发者可手动管理连接的生命周期,在服务器端使用接收客户端连接后,通过循环调用和实现数据的持续收发,同时结合多线程、多进程或I/O多路复用(如epoll、kqueue)技术处理并发连接,这种方式灵活性高,但需开发者自行处理连接异常、心跳检测等细节,开发成本较大。

基于HTTP/HTTPS的长连接(HTTP Keep-Alive)

HTTP/1.1协议默认支持长连接,通过请求头

Connection: keep-alive

告知服务器在响应后保持连接,后续请求可复用该连接,避免重复建立TCP连接的开销,服务器需配置

KeepAliveTimeout

参数(如Nginx中默认为75秒),控制连接的最大空闲时间,HTTP/2进一步通过多路复用技术,允许在单个连接上并行传输多个请求,大幅提升长连接的效率。

基于应用层协议的长连接

针对实时性要求高的场景(如即时通讯、实时推送),应用层常基于TCP或UDP自定义长连接协议。

长连接的核心优势与潜在挑战

优势:

挑战:

长连接的典型应用场景

长连接凭借高效性和实时性,在多个领域得到广泛应用:

服务器设置长连接的最佳实践

为确保长连接的稳定性和高效性,服务器端需遵循以下设计原则:

合理配置连接参数

高效的连接管理策略

容错与监控机制

服务器设置长连接是提升通信效率、优化用户体验的重要手段,但也需在资源占用、管理复杂度和容错能力之间找到平衡,开发者需根据业务场景选择合适的协议和技术方案,通过合理的参数配置、高效的连接管理和完善的监控机制,充分发挥长连接的优势,同时规避潜在风险,随着5G、物联网和实时应用的普及,长连接技术将继续在低延迟、高并发的互联网架构中扮演核心角色,推动服务性能和用户体验的持续提升。

发表评论