Redis:磁盘读取实现快速运行

Redis是一款高性能的键值数据库,它采用了内存存储的方式,相比于传统的磁盘存储,Redis的读写速度更加快速,而且有着非常高的并发能力。

然而,由于Redis采用的是内存存储,所以它的内存空间是非常有限的,如果数据规模太大就会出现内存不足的情况。为了解决这个问题,Redis提供了一种磁盘读取的方式,可以将数据存储到磁盘上,使得Redis的读写速度也非常快。

那么,如何实现Redis的磁盘读取呢?以下是一些实现方法:

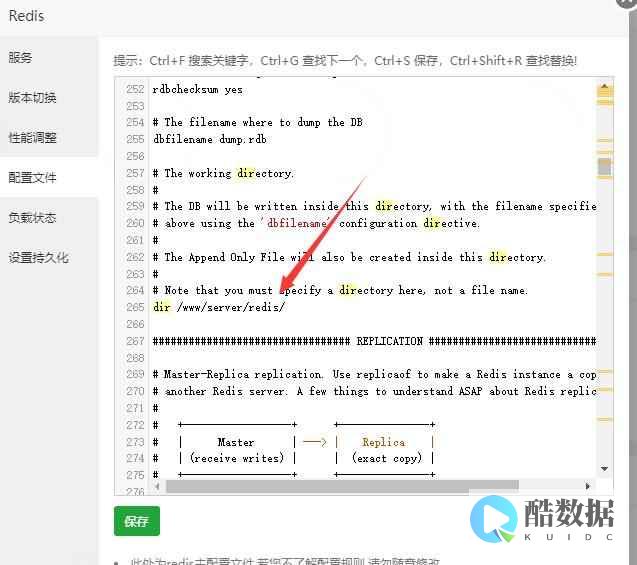

1.使用Redis的持久化功能

Redis提供了两种持久化方式,分别是RDB和AOF。其中RDB(Redis>香港服务器首选树叶云,2H2G首月10元开通。树叶云(www.IDC.Net)提供简单好用,价格厚道的香港/美国云 服务器 和独立服务器。IDC+ISP+ICP资质。ARIN和APNIC会员。成熟技术团队15年行业经验。

什么是redis呢,求通俗解释

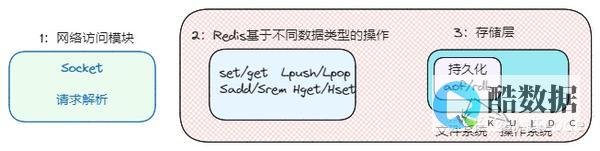

Redis是一个开源的使用ANSI c语言编写、支持网络、可基于内存亦可持久化的日志型、Key-Value数据库,并提供多种语言的API。 从2010年3月15日起,Redis的开发工作由VMware主持。 redis是一个key-value存储系统。 和Memcached类似,它支持存储的value类型相对更多,包括string(字符串)、list(链表)、set(集合)、zset(sorted set --有序集合)和hash(哈希类型)。 这些数据类型都支持push/pop、add/remove及取交集并集和差集及更丰富的操作,而且这些操作都是原子性的。 在此基础上,redis支持各种不同方式的排序。 与memcached一样,为了保证效率,数据都是缓存在内存中。 区别的是redis会周期性的把更新的数据写入磁盘或者把修改操作写入追加的记录文件,并且在此基础上实现了master-slave(主从)同步。 Redis 是一个高性能的key-value数据库。 redis的出现,很大程度补偿了memcached这类key/value存储的不足,在部 分场合可以对关系数据库起到很好的补充作用。 它提供了Python,Ruby,Erlang,PHP客户端,使用很方便。 [1]Redis支持主从同步。 数据可以从主服务器向任意数量的从服务器上同步,从服务器可以是关联其他从服务器的主服务器。 这使得Redis可执行单层树复制。 从盘可以有意无意的对数据进行写操作。 由于完全实现了发布/订阅机制,使得从数据库在任何地方同步树时,可订阅一个频道并接收主服务器完整的消息发布记录。 同步对读取操作的可扩展性和数据冗余很有帮助。

碎片整理有什么好处?

实际上,定期整理硬盘应该是毫无疑问的。 如果说硬盘碎片整理真的会损害硬盘的话,那也将是在对硬盘进行近乎天文数字般次数的整理之后。 硬盘使用的时间长了,文件的存放位置就会变得支离破碎——文件内容将会散布在硬盘的不同位置上。 这些“碎片文件”的存在会降低硬盘的工作效率,还会增加数据丢失和数据损坏的可能性。 碎片整理程序把这些碎片收集在一起,并把它们作为一个连续的整体存放在硬盘上。 Windows自带有这样的程序:磁盘碎片整理程序(DiskDefragmenter),但在工具软件NortonUtilities和Nuts&Bolts中有更好的此类程序。 然而,碎片整理对硬盘里的运转部件来说的确是一项不小的工作。 如果硬盘已经到了它生命的最后阶段,碎片整理的确有可能是一种自杀行为。 但在这种情况下,即使您不进行碎片整理,硬盘也会很快崩溃的。 实际上在大多数情况下,定期的硬盘碎片整理减少了硬盘的磨损。 不管怎么说,让硬盘的磁头从1处读取文件总比从8处读取要容易得多。 因此,一个每两周或四周整理一次的硬盘的寿命应当比一个永远不整理的硬盘长。

scrapy使用redis的时候,redis需要进行一些设置吗

1.使用两台机器,一台是win10,一台是centos7,分别在两台机器上部署scrapy来进行分布式抓取一个网站7的ip地址为192.168.1.112,用来作为redis的master端,win10的机器作为的爬虫运行时会把提取到的url封装成request放到redis中的数据库:“dmoz:requests”,并且从该数据库中提取request后下载网页,再把网页的内容存放到redis的另一个数据库中“dmoz:items”从master的redis中取出待抓取的request,下载完网页之后就把网页的内容发送回master的redis5.重复上面的3和4,直到master的redis中的“dmoz:requests”数据库为空,再把master的redis中的“dmoz:items”数据库写入到mongodb中里的reids还有一个数据“dmoz:dupefilter”是用来存储抓取过的url的指纹(使用哈希函数将url运算后的结果),是防止重复抓取的!

发表评论