服务器负载均衡的实现

在现代互联网架构中,服务器负载均衡是确保系统高可用性、扩展性和性能的关键技术,随着用户量的增长和业务复杂度的提升,单一服务器往往难以承受巨大的并发请求,负载均衡通过将流量合理分配到后端多台服务器,避免了单点故障,提升了整体服务的稳定性和响应速度,本文将详细介绍服务器负载均衡的实现原理、常见算法、部署模式及实践中的注意事项。

负载均衡的核心原理

负载均衡的核心思想是通过特定的策略将外部请求分发到后端多个服务器节点,从而实现资源的合理利用,其基本架构通常包括三个部分: 负载均衡器(Load Balancer) 、 后端服务器集群 和 健康检查机制 ,负载均衡器作为流量的入口,接收客户端请求后根据预设算法选择目标服务器;后端服务器集群负责实际处理请求;健康检查机制则实时监控服务器状态,确保将请求仅转发到正常工作的节点。

负载均衡可分为 四层(传输层) 和 七层(应用层) 两种类型,四层负载均衡基于IP地址和端口进行流量分发,如TCP/UDP协议,性能较高但缺乏对应用层内容的理解;七层负载均衡则深入应用层,可基于HTTP头、Cookie、URL等智能分配流量,灵活性更强但性能相对较低。

常见的负载均衡算法

负载均衡算法的选择直接影响流量分配的公平性和系统性能,常见的算法包括以下几种:

负载均衡的部署模式

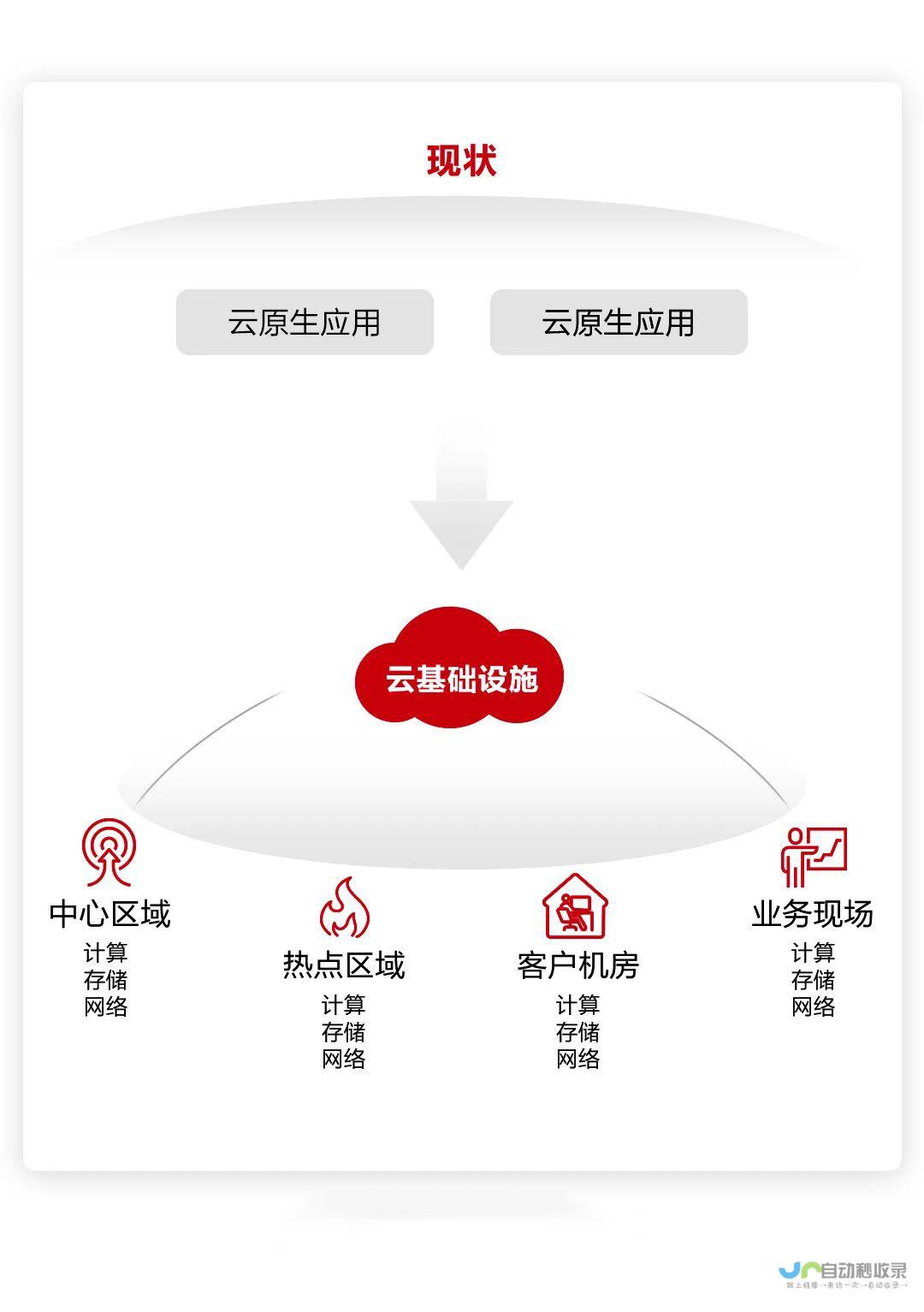

根据部署位置和架构不同,负载均衡可分为以下几种模式:

实践中的关键注意事项

服务器负载均衡是构建高可用互联网架构的基石,通过合理的算法选择、部署模式设计和实践优化,可有效提升系统的稳定性和性能,从硬件设备到云服务,从四层到七层负载均衡,技术方案需根据业务场景灵活选择,随着微服务、容器化技术的发展,负载均衡将更加智能化和自动化,为复杂业务提供更强大的支撑,在实际应用中,需持续关注性能、安全与可维护性的平衡,确保负载均衡架构长期稳定运行。

发表评论