由浅到深学习Kafka:生产者消息分区机制原理

作者:架构师的修炼之路 2020-04-17 14:49:34在使用Apache Kafka生产和消费消息的时候,肯定是希望能够将数据均匀地分配到所有 服务器 上。比如很多公司使用Kafka收集应用服务器的日志数据,这种数据都是很多的,特别是对于那种大批量机器组成的集群环境,每分钟产生的日志量都能以GB数,因此如何将这么大的数据量均匀地分配到Kafka的各个Broker上,就成为一个非常重要的问题。

在使用Apache Kafka生产和消费消息的时候,肯定是希望能够将数据均匀地分配到所有服务器上。

比如很多公司使用Kafka收集应用服务器的日志数据,这种数据都是很多的,特别是对于那种大批量机器组成的集群环境,每分钟产生的日志量都能以GB数,因此如何将这么大的数据量均匀地分配到Kafka的各个Broker上,就成为一个非常重要的问题。

为什么分区?

Topic的概念,它是承载真实数据的逻辑容器,而在主题之下还分为若干个分区,也就是说Kafka的消息组织方式实际上是三级结构:主题-分区-消息。主题下的每条消息只会保存在某一个分区中,而不会在多个分区中被保存多份。官网上的这张图非常清晰地展示了。

Kafka的三级结构,如下所示:

看到了这张图,我有几个问题,为什么Kafka要做这样的设计?为什么使用分区而不是直接使用多个Topic呢?

分区的作用

其实,分区的作用就是提供负载均衡的能力,或者说对数据进行分区的主要原因,就是为了实现系统的高伸缩性(Scalability)

不同的分区能够被放置到不同节点的机器上,而数据的读写操作也都是针对分区这个粒度而进行的,这样每个节点的机器都能独立地执行各自分区的读写请求处理,并且,我们还可以通过添加新的节点机器来增加整体系统的吞吐量

实际上分区的概念以及分区数据库早在1980年就已经有大牛们在做了,比如那时候有个叫Teradata的数据库就引入了分区的概念

在不同的分布式系统对分区的叫法也不尽相同:比如在Kafka中叫分区,在MongoDB和Elasticsearch中就叫分片Shard,而在HBase中则叫Region,在Cassandra中又被称作vnode

从表面看起来,它们实现原理可能不尽相同,但对底层分区(Partitioning)的整体思想却从未改变

除了提供负载均衡这种最核心的功能之外,利用分区也可以实现其他一些业务级别的需求,比如实现业务级别的消息顺序的问题

Kafka中的分区策略

Kafka中的分区策略,就是决定生产者将消息发送到哪个分区的算法

Kafka提供了默认的分区策略,同时,也支持自定义分区策略

默认分区策略

轮询策略

也称Round-robin策略,即顺序分配

比如一个主题下有3个分区,那么第一条消息被发送到分区0,第二条被发送到分区1,第三条被发送到分区2,以此类推。当生产第4条消息时又会重新开始,即将其分配到分区0,如下图所示

如果你未指定partitioner.class参数,那么你的生产者程序会按照轮询的方式在Topic的所有分区间均匀地“存放”消息

轮询策略有非常优秀的负载均衡表现,它总是能保证消息最大限度地被平均分配到所有分区上,默认情况下它是最合理的分区策略,也是我们最常用的分区策略之一

随机策略

也称Randomness策略,所谓随机就是我们随意地将消息放置到任意一个分区上,如下图所示

如果要实现随机策略版的partition方法,很简单,只需要两行代码即可:

先计算出该Topic总的分区数,然后随机地返回一个小于它的正整数

本质上看随机策略也是力求将数据均匀地打散到各个分区,但从实际表现来看,它要逊于轮询策略,所以如果追求数据的均匀分布,还是使用轮询策略比较好

事实上,随机策略是老版本生产者使用的分区策略,在新版本中已经改为轮询了

消息键策略

也称Key-ordering策略,Kafka允许为每条消息定义消息键,简称为Key

这个Key的作用非常大,它可以是一个有着明确业务含义的字符串,比如客户代码、部门编号或是业务ID等;也可以用来表征消息元数据

特别是在Kafka不支持时间戳的年代,在一些场景中,工程师们都是直接将消息创建时间封装进Key里面的

一旦消息被定义了Key,那么你就可以保证同一个Key的所有消息都进入到相同的分区里面,由于每个分区下的消息处理都是有顺序的,故这个策略被称为按消息键策略,如下图所示

实现这个策略的partition方法同样简单,只需要下面两行代码即可:

先计算出该Topic总的分区数,然后计算出key的hashCode与分区数取模的绝对值

Kafka在默认分区策略的选择:如果指定了Key,那么默认实现按消息键策略;如果没有指定Key,则使用轮询策略

地理分区策略

上面这几种分区策略都是比较基础的策略,其实还有一种比较常见的,即所谓的基于地理位置的分区策略

当然这种策略一般只针对那些大规模的Kafka集群,特别是跨城市、跨国家甚至是跨大洲的集群

自定义分区策略

说完了默认分区,来说说自定义分区

Kafka中如果要自定义分区策略,你需要显式地配置生产者端的参数partitioner.class

这个参数该怎么设定呢?方法很简单,在编写生产者程序时,你可以编写一个具体的类实现org.apache.kafka.clients.producer.Partitioner接口

这个接口也很简单,只定义了两个方法:partition()和close(),通常你只需要实现最重要的partition方法,代码如下所示

这里的topic、key、keyBytes、value和valueBytes都属于消息数据,cluster则是集群信息(比如当前Kafka集群共有多少主题、多少Broker等)

Kafka给你这么多信息,就是希望让你能够充分地利用这些信息对消息进行分区,计算出它要被发送到哪个分区中

只要你自己的实现类定义好了partition方法,同时设置partitioner.class参数为你自己实现类的Full Qualified Name,那么生产者程序就会按照你的代码逻辑对消息进行分区

结语

今天学习了Kafka生产者消息分区的机制以及常见的几种分区策略

分区是实现负载均衡以及高吞吐量的关键,故在生产者这一端就要仔细盘算合适的分区策略,避免造成消息数据的倾斜,使得某些分区成为性能瓶颈,这样极易引发下游数据消费的性能下降

大数据云计算好不好学习?

学习大数据处理需要的语言:javaMR语言这种语言产生很早了,大家也或多或少的接触过,但是在大数据中使用已经有的原型进行构建庞大系统,是一种基本的选择。 Scala语言以java为基础的语言,和java很像,对任何想要进行大规模的机械学习或是建立高阶的算法,Scala是逐渐兴起的工具,善于呈现且拥有建立可靠系统的能力。 Hadoop在以java为基础的大数据处理当中,Hadoop为作一批数据处理,发展以java为基础的架构关键。 相对于其他处理工具而言,Hadoop慢许多,但是无比的准确可被后端数据库分析广泛使用Kafka andStorm它是一个特别快速的查询信息系统,但是因为太快了在实施操作时会犯错,有时候会漏掉东西。 Pythom语言Python拥有R语言处理复杂数据的能力及更务实的语言特质,更简单和直观,在近几年的成长很快。 在数据处理范畴内,通常在规模与复杂之间要有个选择,Python无疑当选。

大数据学习一般要多少学费

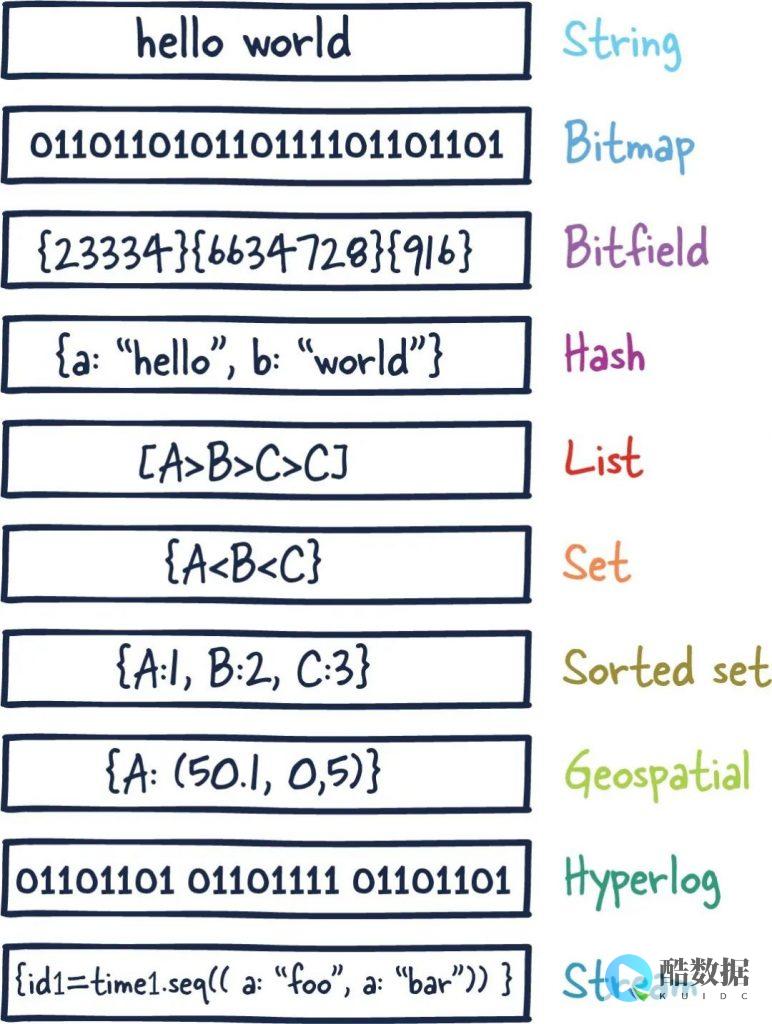

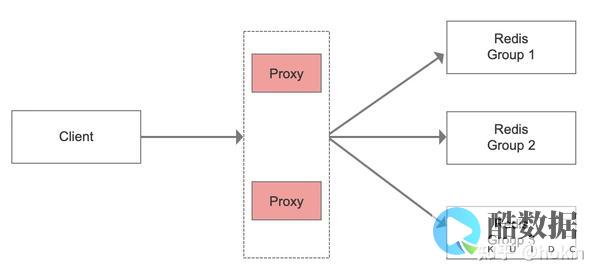

4-6个月左右,包含java和大数据的学-习,如下:基础阶段:linux、docker、kvm、mysql基础、oracle基础、mongodb、Redis。 hadoop mapreduce hdfs yarn:hadoop:hadoop 概念、版本、历史,hdfs工作原理,yarn介绍及组件介绍。 大数据存储阶段:hbase、hive、sqoop。 大数据架构设计阶段:flume分布式、zookeeper、kafka。 大数据实时计算阶段:mahout、spark、storm。 大数据数据采集阶段:python、scala。 大数据商业实战阶段:实操企业大数据处理业务场景,分析需求、解决方案实施,综合技术实战应用。 大数据分析的几个方面:1、可视化分析:可视化分析能够直观的呈现大数据特点,同时能够非常容易被读者所接受,就如同看图说话一样简单明了。 2、数据挖掘算法:大数据分析的理论核心就是数据挖掘算法。 3、预测性分析:从大数据中挖掘出特点,通过科学的建立模型,从而预测未来的数据。 4、语义引擎:需要设计到有足够的人工智能以足以从数据中主动地提取信息。 5、数据质量和数据管理:能够保证分析结果的真实性

学习大数据需要哪些基础

一般需要了解一些算法基础,还需要有一定的语言基础,最好是JAVA语言的基础.

不过这些基础还是需要建立在你勤奋学习上的,不是有了这些基础你就能学好.

所以你想学一门东西的时候,持之以恒才是最重要的.

发表评论