{GPU计算服务器区别在哪}

在数字经济快速发展的背景下,GPU计算服务器已成为AI训练、3D渲染、科学计算等领域的核心基础设施,不同GPU计算服务器的区别体现在硬件架构、性能参数、适用场景等方面,正确选择能最大化资源利用效率,降低成本,本文将从硬件核心差异、内存与存储配置、网络与I/O性能、散热与功耗设计、适用场景五个维度展开,并结合 酷番云 的独家经验案例,帮助读者全面理解GPU计算服务器的区别。

硬件核心差异:GPU芯片与CPU搭配决定性能底色

GPU芯片的类型、CPU的选型及多GPU扩展能力是GPU计算服务器的核心区别点。

内存与存储配置:显存与存储速度决定数据处理瓶颈

显存类型、CPU内存容量及存储方案直接影响数据交换效率。

网络与I/O性能:带宽与扩展能力决定分布式效率

网络带宽、网卡类型及I/O扩展能力影响分布式训练或大规模数据处理的效率。

散热与功耗设计:散热技术影响服务器寿命,功耗管理决定成本

散热技术和功耗管理是GPU服务器长期稳定运行的关键。

适用场景差异:针对性配置提升业务效率

不同场景对GPU服务器的配置要求差异显著。

| 场景 | 核心需求 | 推荐配置 | 酷番云案例 |

|---|---|---|---|

| AI训练 | 大显存、高带宽 | A100/H100+Xeon+RDMA | 为某AI初创公司定制A100双卡服务器,支持40GB显存、900GB/s带宽,训练速度提升40% |

| 3D渲染 | 高计算能力、高显存 | RTX 4090/4090 Ti+Xeon+NVMe SSD | 为影视公司提供8卡RTX 4090渲染服务器,渲染时间缩短30% |

| 科学计算 | 稳定、多核 | Xeon+RDMA+NVMe SSD | 为气候研究中心提供Xeon Gold+RDMA服务器,模拟效率提升25% |

| 数据分析 | 高内存、快速存储 | DDR5+NVMe SSD | 为金融公司提供512GB内存+2TB NVMe SSD服务器,数据处理速度提升50% |

酷番云的独家经验案例

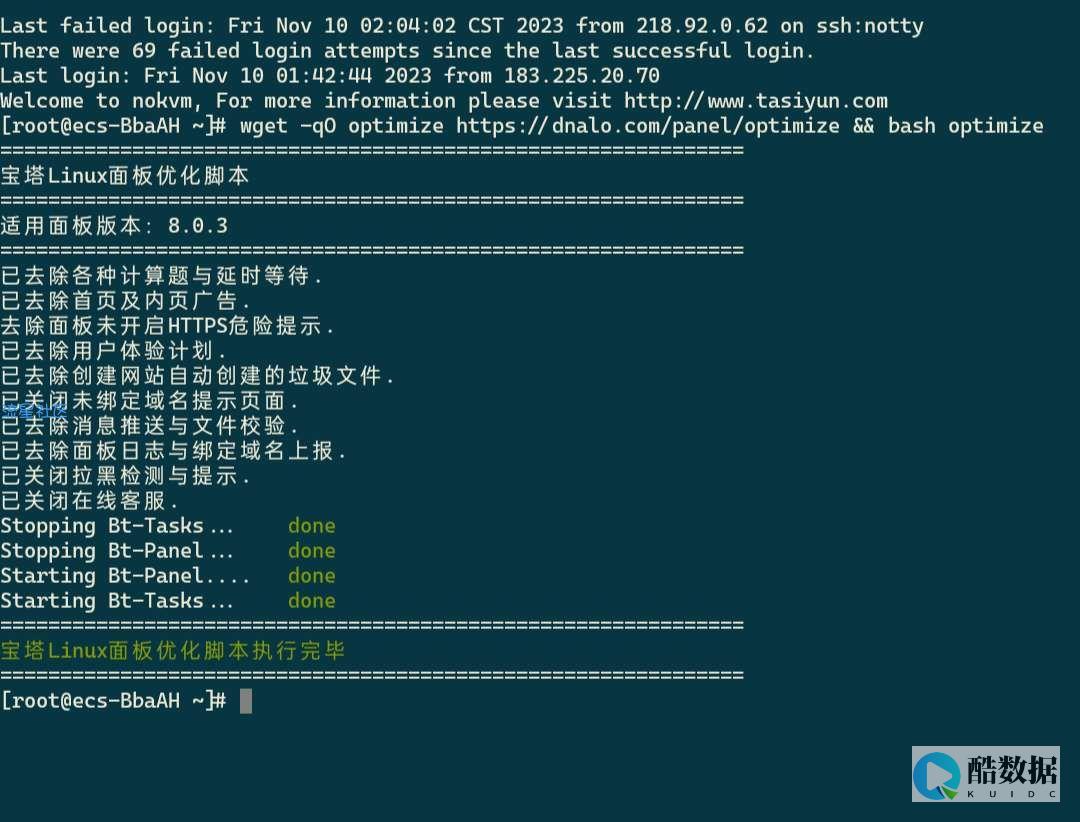

案例1:AI初创公司大模型训练定制 某AI初创公司需训练一个大型语言模型(LLM),要求单卡显存≥40GB、带宽≥900GB/s,酷番云为其定制了NVIDIA A100双卡服务器,配置Xeon Gold 6248 CPU(64核,3.5GHz)、256GB DDR5内存、2TB NVMe SSD、100Gbps RDMA网卡,液冷散热,通过优化数据传输路径(使用RDMA),训练速度提升40%;通过PET模式降低功耗15%,最终帮助该公司提前完成模型迭代,节省成本约20%。

案例2:影视公司3D渲染集群部署 某影视公司需渲染一部3D电影,需8卡RTX 4090渲染能力,酷番云为其提供了定制化机架式服务器,采用风冷散热(适合机架环境),配置8个PCIe 4.0插槽、2000W电源,通过预配置渲染软件(如Octane Render),优化渲染流程,将渲染时间缩短30%;通过KVM虚拟化技术,实现多项目并行渲染,提升资源利用率。

深度问答FAQs

如何根据业务需求选择GPU计算服务器?

GPU服务器升级时需要注意哪些关键点?

通过以上分析,我们可以看到,GPU计算服务器的区别不仅体现在硬件参数上,更体现在对业务需求的适配性上,选择合适的GPU计算服务器,需结合业务场景、数据规模和预算,通过专业厂商(如酷番云)的定制化方案,最大化资源利用效率。

发表评论