随着数字化转型的深入,全球数据量正以每年40%以上的速度增长,据IDC预测,到2025年全球数据圈将达175ZB,面对如此庞大的数据规模,传统集中式数据分析模式在存储容量、计算性能和扩展性上逐渐捉襟见肘,分布式数据分析技术应运而生,它通过将数据和计算任务分散到多个节点,借助分布式系统原理实现高效处理,已成为大数据时代的核心支撑技术。

核心架构与技术基础

分布式数据分析的架构设计围绕“数据分片”与“任务并行”两大核心展开,其基础架构通常分为数据存储层、计算引擎层、资源调度层和用户接口层,数据存储层以分布式文件系统(如HDFS)为基础,将海量数据切分为固定大小的数据块(默认128MB),分散存储在不同节点,并通过多副本机制(默认3副本)保障数据可靠性,计算引擎层则负责解析任务并执行并行计算,早期以MapReduce为代表,采用“分而治之”思想,通过Map阶段完成数据分片处理,Reduce阶段汇总结果;如今以Spark更为流行,基于内存计算优化迭代效率,支持批处理、流处理、机器学习等多种计算模式。

资源调度层是分布式系统的“指挥中心”,通过资源管理器(如YARN、Kubernetes)动态分配计算资源,监控节点状态,确保任务高效执行,用户接口层则提供编程接口(如Spark API、Hive SQL)和可视化工具,降低用户使用门槛,这种分层架构实现了存储与计算的解耦,各层可独立扩展,为系统弹性提供了基础。

关键技术组件

分布式数据分析的落地依赖多项关键技术的协同作用,在数据存储方面,除了分布式文件系统,NoSQL数据库(如HBase、Cassandra)通过列式存储和分片机制,支撑结构化与非结构化数据的高效读写;分布式缓存(如Redis、Memcached)则通过内存存储热点数据,减少磁盘I/O压力。

计算引擎的演进是分布式数据分析的核心驱动力,MapReduce虽简化了并行编程,但因其磁盘中间结果写入导致延迟较高,逐渐被Spark替代,Spark基于DAG(有向无环图)调度引擎,支持内存计算,将迭代计算效率提升10倍以上;而Flink则专注于流处理,通过事件时间处理和Exactly-Once语义,满足金融、物联网等领域的实时性要求。

任务调度与容错机制同样关键,在调度层面,Mesos和Kubernetes通过资源池化管理,实现多框架资源共享;容错方面,Spark的Lineage(血统)记录数据转换过程,节点故障时可重新计算丢失分区,而非简单重启任务,大幅提升系统鲁棒性,分布式协调服务(如ZooKeeper)通过一致性协议(如ZAB)维护节点元数据,确保系统在分布式环境下的状态一致性。

典型应用场景

分布式数据分析已渗透到各行各业,成为驱动业务创新的关键力量,在互联网领域,电商平台通过分布式数据分析处理用户行为日志,构建实时推荐系统:淘宝的TeraSort框架每天需处理PB级用户点击数据,通过Spark Streaming实现毫秒级特征更新,推荐准确率提升15%以上。

金融行业依赖分布式数据分析构建风控体系,传统风控模型因数据处理延迟难以应对实时欺诈,而基于Flink的分布式流处理平台可实时分析交易数据,通过规则引擎和机器学习模型识别异常交易,某股份制银行应用后,欺诈交易识别时效从小时级缩短至秒级,损失率降低40%。

科研领域同样受益于分布式技术,欧洲核子研究中心(CERN)的LHC实验每年产生PB级粒子碰撞数据,通过Hadoop和Spark集群进行分布式处理,科学家可快速分析海量实验数据,验证希格斯玻色子等物理现象,智慧城市中的交通流量分析、医疗领域的基因组测序等场景,均依赖分布式数据分析实现复杂问题的规模化求解。

面临的挑战与解决方案

尽管分布式数据分析优势显著,但其落地仍面临诸多挑战,数据一致性问题是首要难题,在分布式环境下,节点间网络分区或故障可能导致数据副本不一致,为此,业界提出CAP理论权衡,多数系统选择AP(可用性与分区容忍性),通过最终一致性模型(如BASE)牺牲强一致性换取高可用,而金融等场景则采用Paxos、Raft等共识算法实现强一致性。

网络延迟与数据倾斜同样制约性能,跨节点通信可能成为瓶颈,Spark通过广播变量和累加器优化数据传输;数据 skew则导致部分节点负载过高,需通过自定义分区器(如Range Partitioning)或预聚合策略均衡负载,安全与隐私问题日益凸显,分布式环境下的数据泄露风险更高,联邦学习、同态加密等技术可在不暴露原始数据的前提下完成分析,为隐私保护提供新思路。

未来发展趋势

随着技术演进,分布式数据分析正朝着智能化、云原生和实时化方向加速发展,AI与分布式系统的深度融合成为趋势,Spark MLlib和TensorFlowOnSpark支持分布式机器学习训练,自动优化模型参数和资源分配,降低AI应用门槛。

云原生架构推动分布式分析向“Serverless”演进,用户无需管理集群资源,通过函数计算(如AWS Lambda)即可提交任务,实现按需扩展与成本优化,边缘计算与分布式分析的结合逐渐显现,在物联网设备端部署轻量化计算节点,实时处理本地数据,仅将结果回传中心节点,减少带宽压力,提升响应效率。

实时分析能力将持续增强,Flink的统一批流处理架构逐渐成为主流,结合事件时间处理和状态管理,实现从数据产生到决策的全链路实时化,随着量子计算与分布式系统的探索,分布式数据分析有望在算力突破和算法创新的双重驱动下,解锁更复杂的数据价值。

分布式数据分析技术不仅解决了大数据时代的存储与计算瓶颈,更通过架构创新和生态完善,成为数字经济时代的基础设施,从互联网到传统行业,从科学研究到社会治理,其价值正在持续释放,随着技术的不断迭代,分布式数据分析将更加智能、高效、普惠,为各行业的数字化转型注入强劲动力。

谈谈RDD,DataFrame,Dataset的区别和各自的优势

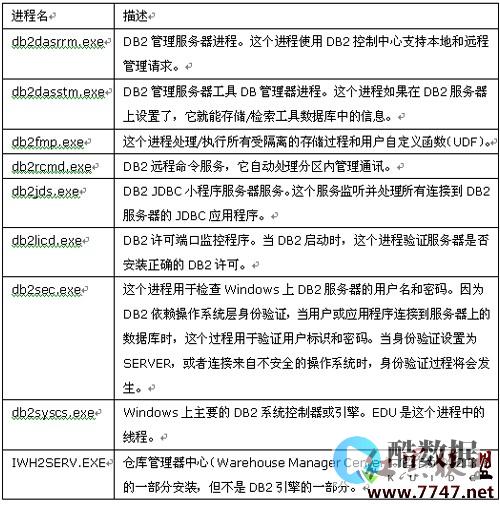

RDD、DataFrame和DataSet是容易产生混淆的概念,必须对其相互之间对比,才可以知道其中异同。 RDD和DataFrameRDD-DataFrame上图直观地体现了DataFrame和RDD的区别。 左侧的RDD[Person]虽然以Person为类型参数,但Spark框架本身不了解Person类的内部结构。 而右侧的DataFrame却提供了详细的结构信息,使得SparkSQL可以清楚地知道该数据集中包含哪些列,每列的名称和类型各是什么。 DataFrame多了数据的结构信息,即schema。 RDD是分布式的Java对象的集合。 DataFrame是分布式的Row对象的集合。 DataFrame除了提供了比RDD更丰富的算子以外,更重要的特点是提升执行效率、减少数据读取以及执行计划的优化,比如filter下推、裁剪等。 提升执行效率RDDAPI是函数式的,强调不变性,在大部分场景下倾向于创建新对象而不是修改老对象。 这一特点虽然带来了干净整洁的API,却也使得Spark应用程序在运行期倾向于创建大量临时对象,对GC造成压力。 在现有RDDAPI的基础之上,我们固然可以利用mapPartitions方法来重载RDD单个分片内的数据创建方式,用复用可变对象的方式来减小对象分配和GC的开销,但这牺牲了代码的可读性,而且要求开发者对Spark运行时机制有一定的了解,门槛较高。 另一方面,SparkSQL在框架内部已经在各种可能的情况下尽量重用对象,这样做虽然在内部会打破了不变性,但在将数据返回给用户时,还会重新转为不可变数据。 利用 DataFrameAPI进行开发,可以免费地享受到这些优化效果。 减少数据读取分析大数据,最快的方法就是 ——忽略它。 这里的“忽略”并不是熟视无睹,而是根据查询条件进行恰当的剪枝。 上文讨论分区表时提到的分区剪枝便是其中一种——当查询的过滤条件中涉及到分区列时,我们可以根据查询条件剪掉肯定不包含目标数据的分区目录,从而减少IO。 对于一些“智能”数据格 式,SparkSQL还可以根据数据文件中附带的统计信息来进行剪枝。 简单来说,在这类数据格式中,数据是分段保存的,每段数据都带有最大值、最小值、null值数量等一些基本的统计信息。 当统计信息表名某一数据段肯定不包括符合查询条件的目标数据时,该数据段就可以直接跳过(例如某整数列a某段的最大值为100,而查询条件要求a> 200)。 此外,Spark SQL也可以充分利用RCFile、ORC、Parquet等列式存储格式的优势,仅扫描查询真正涉及的列,忽略其余列的数据。

如何用elasticsearch分析data

为了支持高可用性与高伸缩性,Elasticsearch本身就是分布式设计的。 从顶层的角度来说,Elasticsearch在索引(或者集合)中保存文档(或者数据记录),每个集合又分解为多个小块,称为分片。 索引越大,所需要分配的分片越多(不必担心会创建过多的分片,它的开销很小)。 取决于Elasticsearch的设置和规模,分片会在集群中均匀地平均分布,有两个原因:出于冗余方面的原因:默认情况下,Elasticsearch为每个分片都准备了一份拷贝,一旦某个节点停机了,备份的分片就能接替它的位置。 出于性能方面的原因:每个查询都发生在某个索引上,并且会在多个分片中并行运行,这种工作流方式是改善性能的关系所在。 如果感觉运行速度缓慢,只需简单地在集群中加入新的机器,Elasticsearch就会自动地将分片与查询进行分布到新添加的机器上。 这种方式让使用Elasticsearch的组织可以自由选择进行纵向扩展(如果节点运行缓慢就升级硬件)或者横向扩展(如果集群整体速度慢就加入更多的节点)。

数据分析需要掌握些什么知识?

数据分析所需要掌握的知识: 数学知识 对于初级数据分析师来说,则需要了解统计相关的基础性内容,公式计算,统计模型等。 当你获得一份数据集时,需要先进行了解数据集的质量,进行描述统计。 而对于高级数据分析师,必须具备统计模型的能力,线性代数也要有一定的了解。

发表评论