神经网络训练作为人工智能技术落地的基础环节,其效率直接决定了模型开发的周期与成本,近年来,图形处理器(GPU)凭借其卓越的并行计算能力,已成为深度学习训练的核心硬件平台,本文将系统阐述GPU在神经网络训练中的核心作用、关键技术流程与性能优化策略,并结合 酷番云 的实践案例,深入解析实际应用中的经验与挑战,最后通过深度问答进一步拓展专业认知,为从业者提供权威、可操作的参考依据。

GPU架构与神经网络训练的适配性

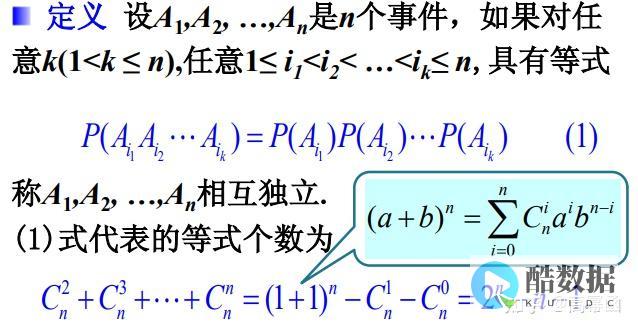

GPU的核心优势在于其大规模并行计算单元(CUDA核心)与专用硬件加速器(如Tensor Cores),以NVIDIA的GPU为例,Tensor Cores通过SIMT(单指令多线程)架构,针对矩阵运算(如卷积、矩阵乘法)进行优化,显著加速深度学习模型的计算密集型操作,在Transformer架构中,自注意力机制的核心计算是矩阵乘法(QK^T V),Tensor Cores能以极高的效率完成此类运算,是BERT、GPT等大模型训练的关键加速点。

结合酷番云的“经验案例”:某金融科技企业需训练一个用于信用评估的深度学习模型(含多个Transformer层与全连接层),选择酷番云的A100 80GB GPU实例,通过利用Tensor Cores加速前向传播中的矩阵运算,结合NVIDIA的AMP(自动混合精度)模块,将FP32训练切换为FP16+FP32混合精度模式,测试结果显示,单节点训练时间从48小时缩短至28小时,训练吞吐量提升约41%,同时因显存占用减半,避免了因显存不足导致的训练中断,体现了GPU架构与深度学习任务的强适配性。

神经网络训练流程的关键环节与GPU的参与

神经网络训练通常包含数据加载、模型前向传播、反向传播、优化器更新等核心环节,GPU在每个环节均发挥关键作用:

性能优化策略与酷番云实践

为最大化GPU在训练中的效能,需采用一系列优化策略:

实际应用案例与酷番云产品结合

以“基于GPU的图像分类模型训练”为例,客户在酷番云的GPU云服务器上部署ResNet-50模型,用于医疗影像分类,通过以下步骤实现高效训练:

![选Windows还是Linux更合适-服务器跑什么系统 (选windows聚焦出来就变回图片,no_ai_sug:false}],slid:206076568393500,queryid:0x1d5bb6cf0a7d71c)](https://www.kuidc.com/zdmsl_image/article/20260130192719_28852.jpg)

发表评论