(3 – 7台)

给现在的企业部署redis集群是一种最佳实践,因为它可以提供更高的可用性和可扩展性,尤其是当存储的数据量变得越来越大的时候。但如果把 服务器 数量算进去,之前已有的优点会因为设备成本而减少。

在部署集群时,最佳实践是使用3至7台服务器,尤其是对于具有高技术水平的业务负载。3台服务器可以提供集群所需的最低冗余,使可用性稳定,它们中的一台可以作为主服务器用于处理客户端的读写请求,另外的两台则用于保持备份数据的准确性。

然而,7台服务器实际上是一个保守的数据库规模,它可以实现更高的性能和可用性。同时,每台服务器之间的负载均衡也会更均衡,大大提高存储操作的速度。

所以,要想部署一个redis集群,使用3-7台服务器是最佳实践。

下面是一些如何部署redis集群的步骤:

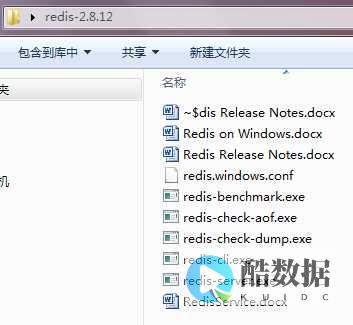

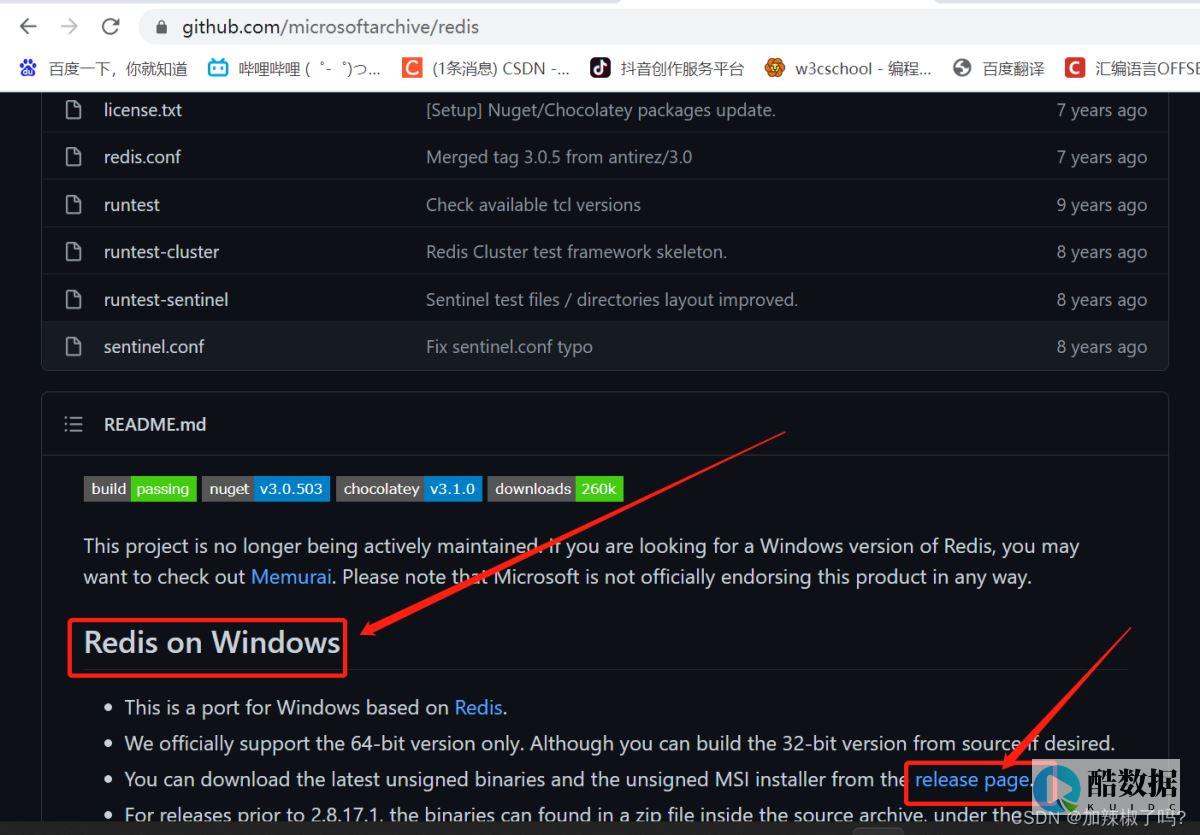

(1)安装redis程序:在集群中的每一台服务器上安装以redis为主的程序。

(2)配置集群:确定redis安装完成之后运行服务,然后提供到集群中的每台服务器,包括它们的IP地址和端口号。

(3)连接服务器:将每一台服务器连接到集群,可以使用如下命令:

redis-cli —–cluster create ip1:port1 ip2:port2…………ip7:port7 —-cluster-replicas 1

(4)添加节点:如果需要增加新节点,使用下面的命令添加。

redis-cli —–cluster add-node ip1:port1 ip2:port2………….ip7:port7 —–cluster-replicas 1

以上是部署redis集群时最佳实践的几台服务器(3 – 7台)的最佳实践指南,它可以使您的集群更快的启动和更高的性能和可用性。

香港服务器首选树叶云,2H2G首月10元开通。树叶云(www.IDC.Net)提供简单好用,价格厚道的香港/美国云服务器和独立服务器。IDC+ISP+ICP资质。ARIN和APNIC会员。成熟技术团队15年行业经验。

如何通过java对redis进行性能测速

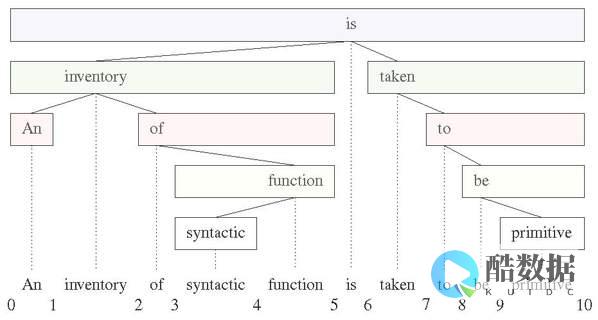

redis是一个key-value存储系统。 和Memcached类似,它支持存储的value类型相对更多,包括string(字符串)、list(链表)、set(集合)、zset(sorted set --有序集合)和hash(哈希类型)。 这些数据类型都支持push/pop、add/remove及取交集并集和差集及更丰富的操作,而且这些操作都是原子性的。 在此基础上,redis支持各种不同方式的排序。 与memcached一样,为了保证效率,数据都是缓存在内存中。 区别的是redis会周期性的把更新的数据写入磁盘或者把修改操作写入追加的记录文件,并且在此基础上实现了master-slave(主从)同步。 Redis 是一个高性能的key-value数据库。 redis的出现,很大程度补偿了memcached这类key/value存储的不足,在部 分场合可以对关系数据库起到很好的补充作用。 它提供了Java,C/C++,C#,PHP,JavaScript,Perl,Object-C,Python,Ruby,Erlang等客户端,使用很方便。 [1] Redis支持主从同步。 数据可以从主服务器向任意数量的从服务器上同步,从服务器可以是关联其他从服务器的主服务器。 这使得Redis可执行单层树复制。 存盘可以有意无意的对数据进行写操作。 由于完全实现了发布/订阅机制,使得从数据库在任何地方同步树时,可订阅一个频道并接收主服务器完整的消息发布记录。 同步对读取操作的可扩展性和数据冗余很有帮助。 redis的官网地址,非常好记,是。 (特意查了一下,域名后缀io属于国家域名,是british Indian Ocean territory,即英属印度洋领地)目前,VMware在资助着redis项目的开发和维护。

怎么才可以学好软件开发?

1. 确定兴趣爱好(WEB开发、桌面软件开发、系统开发、驱动开发、服务器,WEB开发又分为前台和后台以及框架)

2. 查看专业书籍(以图灵系列图书最佳)

3. 在看书的同时以一些小例子来实践

4. 加入到团队中,参与实际系统的研发工作(如果是学生就接手一两个实际项目,或者跟着导师做)

5. 找找自己的不足,看看哪里还需要提高就OK了。

scrapy使用redis的时候,redis需要进行一些设置吗

1.使用两台机器,一台是win10,一台是centos7,分别在两台机器上部署scrapy来进行分布式抓取一个网站7的ip地址为192.168.1.112,用来作为redis的master端,win10的机器作为的爬虫运行时会把提取到的url封装成request放到redis中的数据库:“dmoz:requests”,并且从该数据库中提取request后下载网页,再把网页的内容存放到redis的另一个数据库中“dmoz:items”从master的redis中取出待抓取的request,下载完网页之后就把网页的内容发送回master的redis5.重复上面的3和4,直到master的redis中的“dmoz:requests”数据库为空,再把master的redis中的“dmoz:items”数据库写入到mongodb中里的reids还有一个数据“dmoz:dupefilter”是用来存储抓取过的url的指纹(使用哈希函数将url运算后的结果),是防止重复抓取的!

发表评论