使用Redis集群实现JWT安全认证

在现代应用程序中,安全认证是最基本的要求之一。JWT(JSON Web Token)是一个领域中非常受欢迎的标准,它为应用程序提供了一种安全的认证机制。Redis作为一种强大的NoSQL数据库,它也提供了一种快速、可靠的方式来存储和处理JWT,同时支持对JWT进行验证和解析。本文将介绍如何使用Redis集群实现JWT安全认证。

什么是JWT?

JSON Web Token (JWT) 是一个开放标准 (RFC 7519),它定义了一种紧凑且自包含的方式,用于在各方之间安全地传输信息。它主要用于客户端和 服务器 之间传递基于JSON的安全令牌。该令牌被设计为紧凑、独立和可扩展的,并且具有足够的灵活性,以满足各种应用程序中的需求。

如何使用JWT?

在实际使用中,JWT通常由三个部分组成,分别是Header(头部)、Payload(信息载荷)和Signature(签名)。它们通常是由点分隔符分隔的一段 Base64 编码的字符串。

Header部分:包含了token的元数据信息,例如哪种类型的token、使用的加密算法等。例如:

{"alg": "HS256","typ": "JWT"}

Payload部分:包含了需要传输的信息,例如用户ID、用户角色等。例如:

{"sub": "1234567890","name": "John Doe","iat": 1516239022}

Signature部分:使用Header和Payload部分的信息和一个密钥来签名,以便于验证后台的请求是否有效。例如:

HmacSHA256(base64UrlEncode(header) + "." +base64UrlEncode(payload),secret)

JWT的优点:

1. JWT是基于token的,因此可以避免使用Cookie的一些限制,例如跨域、CSRF攻击等。

2. JWT 是易于扩展的,可以添加任意数量及类型的信息。

3. JWT可以减轻服务器的状态负担,因为服务器不必提前存储session信息,而只需对JWT进行验证和解析即可。

使用Redis集群存储JWT

在实际应用中,我们通常需要在多个应用程序之间共享JWT。为了保证高可用性和可扩展性,我们可以使用Redis作为JWT的存储引擎。Redis提供了键值对操作,支持高速读写,适合用作缓存或存储。

Redis集群是为了提高Redis的可用性和可扩展性而设计的,它将多个Redis实例组合在一起,形成一个单独的数据存储,从而实现进行水平扩展和高可用性。Redis集群可以自动分片和重新分配数据,并使用复制来保证可用性。

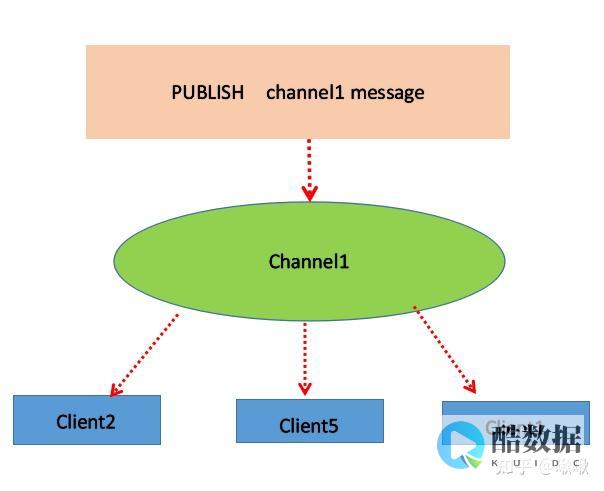

我们可以将JWT的Header和Payload部分存储在Redis集群中,并设置过期时间,以便能够在服务端对JWT进行快速有效的验证。同时,我们可以使用Redis的发布/订阅功能,以便能够在JWT过期时进行相应的处理,例如刷新JWT或删除JWT。

Code示例:

以下是使用Node.js和ioredis(Node.js Redis库)实现以下功能的代码示例:

“`javascript

const Redis = require(‘ioredis’);

const redisCluster = new Redis.Cluster([

{ host: ‘127.0.0.1’, port: 7000 },

{ host: ‘127.0.0.1’, port: 7001 },

{ host: ‘127.0.0.1’, port: 7002 }

// 将 JWT 存储在 Redis 中并设置过期时间

redisCluster.set(jwt, payload, ‘EX’, 300);

// 从 Redis 中获取 JWT 信息

const result = awt redisCluster.get(jwt);

// 发布 JWT 过期消息

redisCluster.publish(‘jwt.expire’, jwt);

总结使用Redis集群存储JWT可以提高应用程序的可用性和可扩展性,同时也可以提高JWT的性能和安全性。在实际应用中,我们可以根据需要选择适当的JWT实现方式以及Redis集群实现方式。

香港服务器首选树叶云,2H2G首月10元开通。树叶云(www.IDC.Net)提供简单好用,价格厚道的香港/美国云服务器和独立服务器。IDC+ISP+ICP资质。ARIN和APNIC会员。成熟技术团队15年行业经验。

memcached和redis的区别

medis与Memcached的区别传统MySQL+ Memcached架构遇到的问题 实际MySQL是适合进行海量数据存储的,通过Memcached将热点数据加载到cache,加速访问,很多公司都曾经使用过这样的架构,但随着业务数据量的不断增加,和访问量的持续增长,我们遇到了很多问题: 需要不断进行拆库拆表,Memcached也需不断跟着扩容,扩容和维护工作占据大量开发时间。 与MySQL数据库数据一致性问题。 数据命中率低或down机,大量访问直接穿透到DB,MySQL无法支撑。 4.跨机房cache同步问题。 众多NoSQL百花齐放,如何选择 最近几年,业界不断涌现出很多各种各样的NoSQL产品,那么如何才能正确地使用好这些产品,最大化地发挥其长处,是我们需要深入研究和思考的问题,实际归根结底最重要的是了解这些产品的定位,并且了解到每款产品的tradeoffs,在实际应用中做到扬长避短,总体上这些NoSQL主要用于解决以下几种问题 1.少量数据存储,高速读写访问。 此类产品通过数据全部in-momery 的方式来保证高速访问,同时提供数据落地的功能,实际这正是Redis最主要的适用场景。 2.海量数据存储,分布式系统支持,数据一致性保证,方便的集群节点添加/删除。 3.这方面最具代表性的是dynamo和bigTable 2篇论文所阐述的思路。 前者是一个完全无中心的设计,节点之间通过gossip方式传递集群信息,数据保证最终一致性,后者是一个中心化的方案设计,通过类似一个分布式锁服务来保证强一致性,数据写入先写内存和redo log,然后定期compat归并到磁盘上,将随机写优化为顺序写,提高写入性能。 free,auto-sharding等。 比如目前常见的一些文档数据库都是支持schema-free的,直接存储json格式数据,并且支持auto-sharding等功能,比如mongodb。 面对这些不同类型的NoSQL产品,我们需要根据我们的业务场景选择最合适的产品。 Redis适用场景,如何正确的使用 前面已经分析过,Redis最适合所有数据in-momory的场景,虽然Redis也提供持久化功能,但实际更多的是一个disk-backed的功能,跟传统意义上的持久化有比较大的差别,那么可能大家就会有疑问,似乎Redis更像一个加强版的Memcached,那么何时使用Memcached,何时使用Redis呢?如果简单地比较Redis与Memcached的区别,大多数都会得到以下观点: 1Redis不仅仅支持简单的k/v类型的数据,同时还提供list,set,zset,hash等数据结构的存储。 2Redis支持数据的备份,即master-slave模式的数据备份。 3Redis支持数据的持久化,可以将内存中的数据保持在磁盘中,重启的时候可以再次加载进行使用。 抛开这些,可以深入到Redis内部构造去观察更加本质的区别,理解Redis的设计。 在Redis中,并不是所有的数据都一直存储在内存中的。 这是和Memcached相比一个最大的区别。 Redis只会缓存所有的 key的信息,如果Redis发现内存的使用量超过了某一个阀值,将触发swap的操作,Redis根据“swappability = age*log(size_in_memory)”计 算出哪些key对应的value需要swap到磁盘。 然后再将这些key对应的value持久化到磁盘中,同时在内存中清除。 这种特性使得Redis可以 保持超过其机器本身内存大小的数据。 当然,机器本身的内存必须要能够保持所有的key,毕竟这些数据是不会进行swap操作的。 同时由于Redis将内存 中的数据swap到磁盘中的时候,提供服务的主线程和进行swap操作的子线程会共享这部分内存,所以如果更新需要swap的数据,Redis将阻塞这个 操作,直到子线程完成swap操作后才可以进行修改。 使用Redis特有内存模型前后的情况对比: VM off: 300k keys, 4096 bytes values: 1.3G used VM on:300k keys, 4096 bytes values: 73M used VM off: 1 million keys, 256 bytes values: 430.12M used VM on:1 million keys, 256 bytes values: 160.09M used VM on:1 million keys, values as large as you want, still: 160.09M used当 从Redis中读取数据的时候,如果读取的key对应的value不在内存中,那么Redis就需要从swap文件中加载相应数据,然后再返回给请求方。 这里就存在一个I/O线程池的问题。 在默认的情况下,Redis会出现阻塞,即完成所有的swap文件加载后才会相应。 这种策略在客户端的数量较小,进行 批量操作的时候比较合适。 但是如果将Redis应用在一个大型的网站应用程序中,这显然是无法满足大并发的情况的。 所以Redis运行我们设置I/O线程 池的大小,对需要从swap文件中加载相应数据的读取请求进行并发操作,减少阻塞的时间。 如果希望在海量数据的环境中使用好Redis,我相信理解Redis的内存设计和阻塞的情况是不可缺少的。

nginx实现tomcat集群的负载均衡有几种方式

一,如果仅是对外提供一个页面访问,不用区分单一用户(不区分每个访问session,不涉及用户权限,用户资料等内容),仅仅配置nginx负载均衡策略即可。 nginx负载均衡策略主要分一下四种:1)、轮询(默认)每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器宕机,能自动剔除。 2)、ip_hash 每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器。 3)、fair 按后端服务器的响应时间来分配请求,响应时间短的优先分配。 4)、url_hash 按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,后端服务器为缓存时比较有效。 二,如果涉及到用户session,做一些鉴权缓存、存放临时信息时,就必须做tomcat的session共享。 目前可参考到的session共享方式主要分为两种。 1)利用tomcat自带的组播机制,实现session复制。 对tomcat及应用的若干配置文件进行配置即可实现,网上有很多资料可参考。 但这种方式些弊端,看过一些资料,不建议用session复制的方式。 在实际使用过程中,也发现有存在session莫名失踪的现象。 2)利用第三方机制存储session。 比较常见的是tomcat集成memcached服务器来存储session。 实际项目中,我们采用过利用redis实现session存储,redis高效的存取性能为高效的访问提供了保障,但是目前redis的集群功能似乎没有发布,如何解决redis的单点故障需要研究。

PHP 如何在Redis中实现事物(事物提交和事物

public function index(){$serv = new \swoole_server(0.0.0.0, 9501);$serv->set([worker_num => 1,//一般设置为服务器cpu数的1-4倍task_worker_num => 8,//task进程的数量daemonize => 1,//以守护进程执行max_request => ,//最大请求数量task_ipc_mode => 2 //使用消息队列通信,并设置为争抢模式]);$serv->on(Receive, [$this, onReceive]);//接收任务,并投递$serv->on(Task, [$this, onTask]);//可以在这个方法里面处理任务$serv->on(Finish, [$this, onFinish]);//任务完成时候调用$serv->start();}

发表评论