单点登录系统是指将不同系统、应用合并到一个登录入口,用户仅需要一次认证,便可以访问所有的资源,无需繁琐的重复验证。近年来,随着互联网的发展,单点登录组件在企业系统中得到了广泛应用。本文基于Redis缓存解决方案,介绍如何搭建一个基于单点登录的系统。

我们需要准备一台Redis 服务器 ,用来缓存系统以及用户登录信息。然后,需要在每台需要安装单点登录的服务器上安装Redis组件,安装完成后启动Redis服务器,并开启相应的端口监听服务。

接下来,在每个应用服务器上安装单点登录解决方案的相关组件,在应用的配置文件中加入以下配置:

//单点登录配置

sso.redis.IDC.com/xtywjcwz/17304.html" target="_blank">hostname=主机地址

sso.redis.port=Redis端口

sso.redis.password=密码

//redis缓存配置

redis.hostname=主机地址

redis.port=Redis端口

redis.password=密码

上面配置完成之后,我们就可以进行单点登录系统的搭建了。用户在登录应用时,需要在Redis缓存中存储以该用户id为key的信息,其中存储的内容可以是用户的相关信息,也可以是会话令牌。然后用户可以将会话令牌发送给单点登录服务器,如果会话令牌验证通过,则可以登录应用服务器,否则需要重新认证。 综上,本文介绍了基于Redis缓存搭建单点登录系统的方法。经过此种方法的搭建,可以节省用户重复登录的繁琐步骤,提高登录效率和安全性,也会给用户更好的用户体验。

香港服务器首选树叶云,2H2G首月10元开通。树叶云(www.IDC.Net)提供简单好用,价格厚道的香港/美国云服务器和独立服务器。IDC+ISP+ICP资质。ARIN和APNIC会员。成熟技术团队15年行业经验。

大数据学习一般要多少学费

4-6个月左右,包含java和大数据的学-习,如下:基础阶段:linux、docker、kvm、mysql基础、oracle基础、mongodb、redis。 hadoop mapreduce hdfs yarn:hadoop:hadoop 概念、版本、历史,hdfs工作原理,yarn介绍及组件介绍。 大数据存储阶段:hbase、hive、sqoop。 大数据架构设计阶段:flume分布式、zookeeper、kafka。 大数据实时计算阶段:mahout、spark、storm。 大数据数据采集阶段:python、scala。 大数据商业实战阶段:实操企业大数据处理业务场景,分析需求、解决方案实施,综合技术实战应用。 大数据分析的几个方面:1、可视化分析:可视化分析能够直观的呈现大数据特点,同时能够非常容易被读者所接受,就如同看图说话一样简单明了。 2、数据挖掘算法:大数据分析的理论核心就是数据挖掘算法。 3、预测性分析:从大数据中挖掘出特点,通过科学的建立模型,从而预测未来的数据。 4、语义引擎:需要设计到有足够的人工智能以足以从数据中主动地提取信息。 5、数据质量和数据管理:能够保证分析结果的真实性

低代码开发平台哪个比较好?

国内市场上比较好的低代码平台主要有明道云,氚云、白码、简道云这些,这些平台的功能都是相对比较完善的,但是很多平台的操作还是比较复杂的,相对比较简单的就是白码低代码开发平台了,采用可视化的操作界面,只需要拖拽平台内的功能组件就可以进行系统功能的开发,并且白码低代码开发平台提供了多套ERP系统,CRM系统,进销存系统、OA系统的通用模板,通过套用模板的方式,可以简单快速的完成系统的开发,具有开发速度快,开发成本低的优势。

scrapy使用redis的时候,redis需要进行一些设置吗

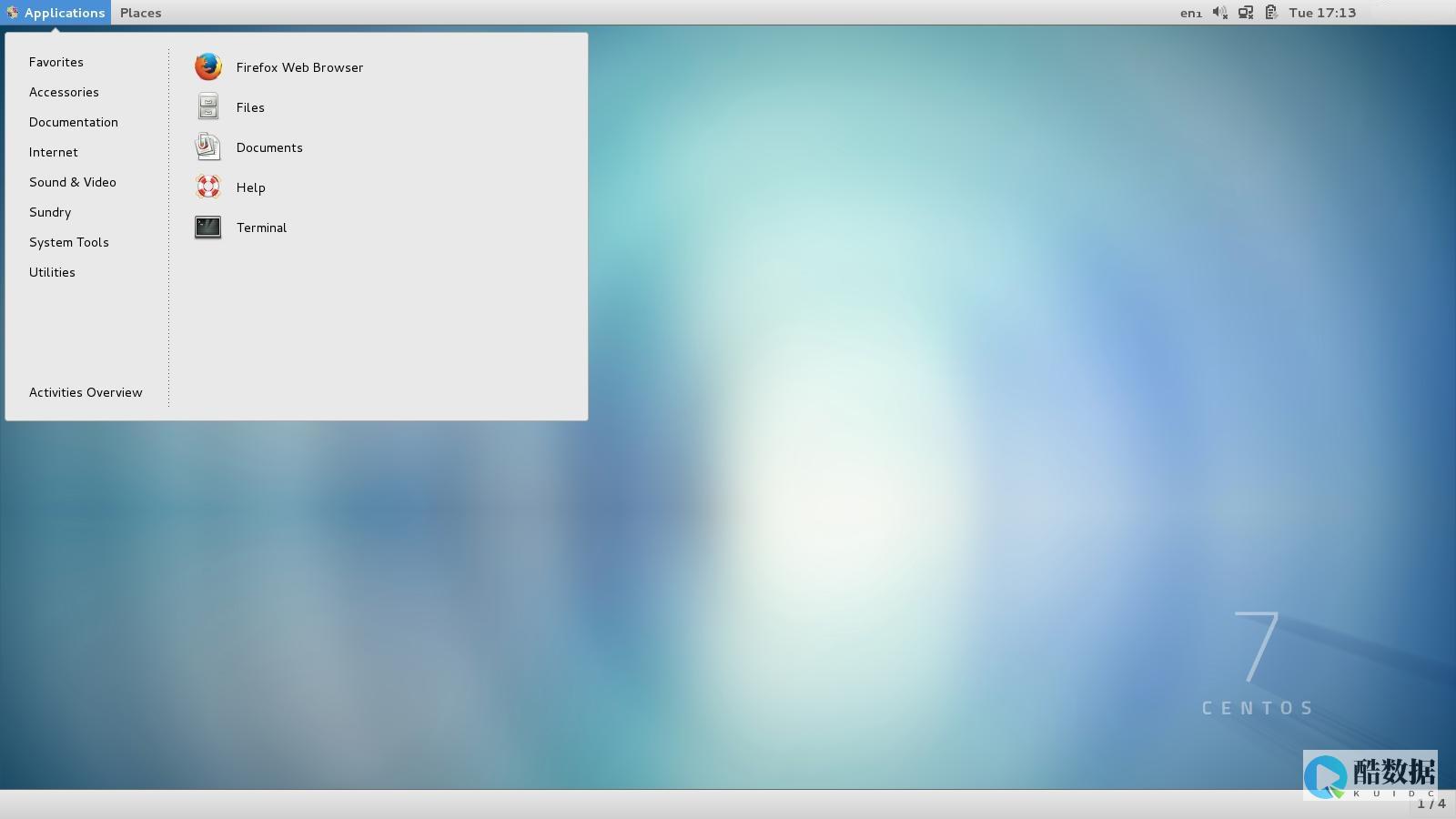

1.使用两台机器,一台是win10,一台是centos7,分别在两台机器上部署scrapy来进行分布式抓取一个网站7的ip地址为192.168.1.112,用来作为redis的master端,win10的机器作为的爬虫运行时会把提取到的url封装成request放到redis中的数据库:“dmoz:requests”,并且从该数据库中提取request后下载网页,再把网页的内容存放到redis的另一个数据库中“dmoz:items”从master的redis中取出待抓取的request,下载完网页之后就把网页的内容发送回master的redis5.重复上面的3和4,直到master的redis中的“dmoz:requests”数据库为空,再把master的redis中的“dmoz:items”数据库写入到mongodb中里的reids还有一个数据“dmoz:dupefilter”是用来存储抓取过的url的指纹(使用哈希函数将url运算后的结果),是防止重复抓取的!

发表评论