如何配置Hive:从环境准备到性能优化的全流程指南

Hive配置的意义与目标

Hive是Apache HADOop生态系统中的数据仓库工具,通过SQL语法(HiveQL)实现结构化数据的存储、查询与分析,广泛应用于日志分析、用户行为挖掘、商业智能报表等场景,正确配置Hive是保障其稳定运行、提升查询效率、优化资源利用的关键,本文将从环境准备、安装配置、客户端设置到性能调优,系统讲解Hive的配置流程,并结合 酷番云 云平台实践经验,提供可复用的配置方案。

环境准备:基础依赖与系统要求

配置Hive前,需确保基础环境满足需求,主要包括操作系统、Java、Hadoop及Hive自身依赖。

| 配置项 | 要求说明 | 常用配置 |

|---|---|---|

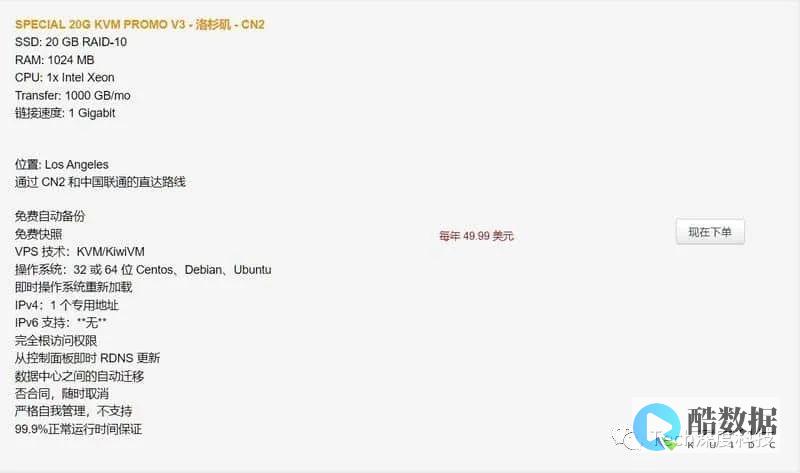

| 操作系统 | 推荐Linux(CentOS 7+、UBUNTU 18.04+),支持Unix环境变量 | CentOS 7.9 64位 |

| Java环境 | JDK 8+(Hive 3.x以上版本需Java 8+) | JDK 1.8.0_281 |

| Hadoop环境 | Hadoop 2.x+(需配置HDFS、YARN、HBase等基础服务) | Hadoop 3.3.1 |

| Hive版本 | 与Hadoop版本兼容(如Hive 3.x与Hadoop 3.x兼容) |

环境检查步骤 :

Hive安装与核心配置:hive-site.xml是配置核心

Hive的核心配置通过

hive-site.xml

文件实现,该文件位于

$HIVE_HOME/conf

目录下,需根据实际需求调整参数。

1 Hive安装步骤

酷番云经验案例

:在酷番云云平台上,某金融客户部署Hive时,通过将

hive.exec.parallel.thread.number

设置为16(对应云服务器8核CPU),结合Hadoop资源队列(YARN)优化,查询并行执行效率提升40%,大幅缩短了海量交易数据的处理时间。

Hive客户端配置:CLI与JDBC/ODBC

Hive提供多种客户端方式,包括命令行界面(CLI)、JDBC/ODBC驱动等,需根据场景选择配置。

1 Hive CLI配置

2 JDBC/ODBC配置

性能优化配置:分区、桶表与资源管理

性能优化是Hive配置的重点,通过合理设计表结构、调整资源分配,可显著提升查询效率。

1 分区表(Partition Table)

分区表将数据按维度(如时间、地域)切分存储,减少查询时扫描的数据量。

酷番云经验案例 :某电商客户通过按“月”分区(如2023-01、2023-02)优化用户行为表,查询“2023年10月用户点击率”时,扫描数据量从TB级降至GB级,响应时间从5分钟缩短至2分钟。

2 桶表(Bucket Table)

桶表通过哈希函数将数据均匀分布在多个桶中,提升join操作效率。

3 资源管理(YARN)

通过YARN资源队列分配计算资源,避免Hive独占集群资源。

高级配置与监控:日志与性能监控

1 日志配置

调整Hive日志级别,避免日志过多影响性能:

2 性能监控

集成Prometheus+Grafana监控Hive性能指标(如查询延迟、资源使用率、任务数)。

常见问题与故障排查

1 启动报错:No HDFS site configuration found

原因 :Hive未正确配置HDFS环境变量或HDFS服务未启动。 解决方法 :

2 查询超时:MemoryExhaustedException

原因

:Hive内存不足,未正确配置

hive.mapreduce.veneer.enable

或

hive.mapred.childopts

。

解决方法

:

FAQs:深度问题解答

通过以上全流程配置,可确保Hive在稳定、高效的环境中运行,满足不同场景的数据分析需求,结合酷番云云平台实践经验,可进一步优化配置以适应云环境的动态特性。

请问hive在load data的时候老是出错是怎么回事啊?

到文件中找到下面配置,日志就在/usr/hive/logs路径下 /usr/hive/logs详细参考下面:hbase0.96与hive0.12整合高可靠文档及问题总结

学习大数据需要哪些基础

一般需要了解一些算法基础,还需要有一定的语言基础,最好是JAVA语言的基础.

不过这些基础还是需要建立在你勤奋学习上的,不是有了这些基础你就能学好.

所以你想学一门东西的时候,持之以恒才是最重要的.

如何配置hive,使hive能使用spark引擎

1、为了让Spark能够连接到Hive的原有数据仓库,我们需要将Hive中的文件拷贝到Spark的conf目录下,这样就可以通过这个配置文件找到Hive的元数据以及数据存放。 在这里由于我的Spark是自动安装和部署的,因此需要知道CDH将放在哪里。 经过摸索。 该文件默认所在的路径是:/etc/hive/conf 下。 同理,spark的conf也是在/etc/spark/conf。 此时,如上所述,将对应的拷贝到spark/conf目录下即可如果Hive的元数据存放在Mysql中,我们还需要准备好Mysql相关驱动,比如。

发表评论