服务器负载均衡的搭建

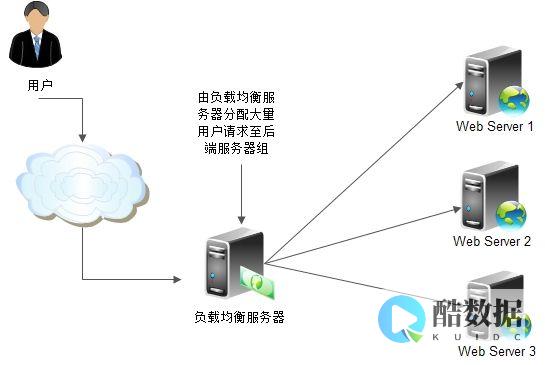

在现代互联网架构中,随着业务量的不断增长,单台服务器往往难以满足高并发、高可用性的需求,服务器负载均衡技术通过将流量分发到多台后端服务器,有效提升系统的处理能力、可靠性和扩展性,本文将详细介绍服务器负载均衡的搭建方法,包括核心原理、常见算法、技术选型及实施步骤。

负载均衡的核心原理

负载均衡的核心在于“分发”与“协调”,客户端的请求首先到达负载均衡器,后者根据预设的策略将请求转发到后端的一台或多台服务器,后端服务器以集群形式存在,共同承担流量压力,避免单点故障,负载均衡器可以工作在OSI模型的不同层级,

负载均衡的常见算法

选择合适的调度算法对负载均衡效果至关重要,常见的算法包括:

技术选型:软件vs硬件

负载均衡的实现方式可分为软件和硬件两类:

对于大多数场景,推荐使用Nginx或HAProxy作为软件负载均衡器,结合Keepalived实现高可用。

搭建步骤:以Nginx为例

以下以Nginx为例,演示负载均衡的搭建过程:

环境准备

配置后端服务器

确保后端服务器能正常响应HTTP请求,在192.168.1.10的Nginx配置中设置默认页面:

Server {listen 80;server_name localhost;loCation / {root /usr/share/nginx/html;index index.html;}}

重启Nginx服务后,通过浏览器访问测试。

配置负载均衡服务器

在负载均衡服务器的Nginx配置文件(

/etc/nginx/nginx.conf

)中添加 upstream 模块和代理配置:

http {upstream backend_servers {server 192.168.1.10:80 weight=3;server 192.168.1.11:80 weight=2;least_conn;}server {listen 80;server_name lb.example.com;location / {proxy_passHost $host;proxy_set_header X-Real-IP $remote_addr;}}}

启动与测试

重启Nginx服务后,通过访问负载均衡器的地址(),观察请求是否被分发到后端服务器,可通过查看后端服务器的访问日志确认流量分配情况。

高可用配置(可选)

为避免负载均衡器单点故障,可结合Keepalived实现双机热备,在两台负载均衡服务器上分别配置Keepalived,虚拟一个VIP(如192.168.1.100),主节点故障时自动切换至备用节点。

优化与监控

服务器负载均衡是提升系统性能和可靠性的关键技术,通过合理选择算法、工具和配置,可以有效分散流量压力,确保业务稳定运行,本文以Nginx为例,详细介绍了从环境准备到配置优化的完整流程,实际应用中可根据业务需求灵活调整方案,随着容器化和微服务架构的普及,基于KuberNetes的Ingress负载均衡也将成为重要趋势。

怎样用两条电信宽带组建一个局域网?

大家不要相互争论了,我们来这里,无非是帮助别人解决问题而已。 首先楼主没有说电信宽带接入的方式:专线五类双绞线(最高100M),还是ADSL电话线(最高8M),还是光纤(FDDI)转五类双绞线(这个通常叫xDSL)。 1-对于网线进户接入的,可以这样做: 软件解决方法:要是想效率高又的话,不考虑共用交换机,可以给性能高的PC装3块网卡,2块接宽带进来的RJ-45头的网线,一块网卡做输出,连接交换机给局域网用。 随便装个什么代理软件就行了,WinRote/Wingage/Sygate等等都行,如果使用WinXPPro,什么软件都可以不装,用建立个网桥就可以把2条线路直接做负载均衡,2条线路谁的负载轻,用户就会自动转向那里所以叫负载均衡。 拨号连接宽带的拨号网络设为共享,其他PC的IP地址设为自动即可。 这样的好处是PC做了防火墙,物理隔绝了外部和内部的网络。 还可以直接把2条进线直接插入局域网的交换机,然后用一台单网卡的计算机接入此交换机,同样安装代理软件或者安装WinxpPro,设置不便,同样整个网络上网,但是因为网络没有隔离,你的计费系统可能会漏计上网费用(如果你给用户按数据计费的话),同时因为局域网整个和宽带直连,安全性会不好,除非你懂网络安全,否则太容易被外部攻克内部的计算机。 这样省了2块网卡,但是有安全隐患,可能害你经常装Pc操作系统。 以上2种方法对用户来说,感觉不到速度和线路质量的差别,但是第2种内部PC中招的机会较大。 2-硬件方法: 花120元左右,买2台桌面5口路由器兼交换机,无论是什么形式入户,都接到2个路由交换机上,然后2个路由交换机再接到内部局域网交换机上,路由交换机上设置2条宽带的帐号即可。 以后所有管理全傻瓜化,只要打开路由交换机电源,所有Pc都可以上网,而且2根线路有1根坏了还能上网。 记得把路由交换机的DHCP服务打开,不然使用静态IP地址分配,一台坏了或者线路1根坏了会上不了网。 用硬件的最大好处是全傻瓜化管理,省事,而且路由交换机既可以接RJ45头的网线,也可以接任何ADSL或者xDSL的modem,甚至是DDN专线,ISDN专线。 同时不怕病毒和一般所谓“黑客”捣乱,但是Money要多花240元,相信你一天的营业额足够了。 最大好处是给你省了一台代理服务器,一台PC再怎样便宜也要花1000元上下的Money。 没听懂的人都继续问,想我们这样专业搞网络的,把这个都看作玩具而已,我这里揭个网络圣殿帐篷的小缝给你们闻闻气味 ^-^ 过节了,大家都开心一下,还是少斗些嘴的好,预注春节快乐!!新年你的网巴发财!!

怎么让两个服务器负载均衡?

很多方法可以实现,比如说系统自带的网络负载均衡也就是我们常说的NLB 如果有条件也可以考虑服务器集群!的搭建,不过服务器集群的搭建相对来说比较复杂!你要做的只是WEB服务器,那我建议你使用网络负载均衡。

广域网加速技术有几大分类?

广域网加速技术主要有一下几种:

1、数据缓存技术

高速缓存技术很早就出现,它主要用来解决带宽瓶颈、应用延迟问题。 目前市场上有一些产品比较典型的就是采用WEB文件缓存和数据字节缓存技术这两种。 将WEB文件缓存到设备中,主要是针对WEB 应用访问,对于TCP应用是没有效果的;另一种是动态缓存,将数据压缩以后按照重复性频率较高的字节以指针的方式缓存于设备中,下次遇到同样的数据时,将直接从缓存中存取。

2、内容分发网络

CDN(Content Delivery Network)是一个经策略性部署的整体系统,能够帮助用户解决分布式存储、负载均衡、网络请求的重定向和内容管理等问题,从而一定程度解决跨越广域网访问互联网服务器的带宽瓶颈、数据丢包、TCP延迟问题。 CDN的目的是通过在现有的Internet中增加一层新的网络架构,将网站的内容发布到最接近用户的网络“边缘”,使用户可以就近取得所需的内容,解决 Internet 网络拥塞状况,提高用户访问网站的响应速度。 此方案对大型网站较为有效。

3、TCP优化及应用优化

专用的TCP加速或应用加速设备可以帮助改善网络环境中的应用性能,如大带宽链路、大文件传输、高时延、相当大的网络交易等。 TCP优化主要解决数据丢包、TCP延迟问题;应用优化主要解决应用延迟问题(如果一个应用在应用层就受到应用消息大小和数据回应及确认需要的限制时,不管带宽有多充裕,也不管是否已经避免了由TCP协议的端到端应答机制造成延迟瓶颈或是TCP的慢启动和拥塞控制行为引起延迟瓶颈,应用延迟不可避免。

目前市场上的专业TCP加速设备及应用加速设备都需要在企业链路的两端部署,代价非常高。 这些专用的加速器都需要自己的专门协议才可以达到加速效果,也就是说基于网络是不透明的。 后果就是,网管人员或系统无法看到正在广域网上运行着的应用,还有必要为这些设备所用的专用传输协议在安全设备上特别打开通道,带来安全隐患。

4、数据压缩

压缩可提高应用性能,创造更大的吞吐率,更快的性能以及更大的网络容量。 压缩可更快地传输数据,让更多的流量通过有限的广域网链路。 当获得更多的带宽时,最关键业务应用的性能便可得到大大的提高。 数据压缩需要设备成对使用,部署在连接的两个端点。

大部分的企业都会在其各个分支机构分别部署一台设备,这样各分支机构之间以及与主站点之间都可以交换流量。 这种部署方案可充分利用整个企业的所有带宽。 每个设备压缩Outbound流量,接收终点的设备解压缩Inbound流量,将流量恢复至原始状态。 数据压缩技术主要解决带宽瓶颈,具有广泛适用性。

5、服务质量控制QoS

服务质量控制或带宽管理QoS有助于减轻带宽的竞争。 对于宝贵的WAN带宽,应用之间会有竞争,控制竞争的一个有效方法是利用带宽分配和服务质量(QoS)工具。

IT人员能够根据应用业务规则分配WAN上应用的优先级,确保该应用能够获得足够的带宽,从而提高与业务紧密相关的生产率。

发表评论